ChatGPT 的惊艳表现让大语言模型 (Large Language Models, LLM) 成为了科技界最炙手可热的焦点。与此同时,Llama、Mistral、Qwen、ChatGLM 等强大的开源 LLM 也如雨后春笋般涌现,它们不仅在性能上紧追商业模型,更重要的是赋予了开发者和企业前所未有的可能性——在自己的服务器上“私有化”部署这些强大的 AI 大脑,实现本地运行的“ChatGPT”。

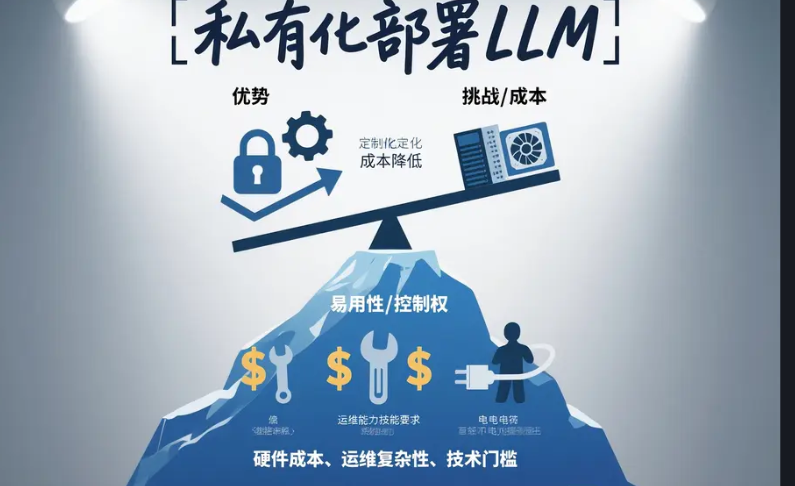

那么,为什么我们要考虑私有化部署 LLM?它真的像听起来那么美好吗?将一个动辄数十亿甚至上千亿参数的庞然大物部署到自己的服务器上,究竟需要付出多少成本?又会面临哪些挑战?本文将深入探讨这些问题,为您揭开私有化部署 LLM 的真实面貌。

为什么要考虑私有化部署 LLM?

相比直接调用 OpenAI、Anthropic 或 Google 等提供的 Cloud API,私有化部署 LLM 主要有以下几个驱动因素:

- 数据隐私与安全: 这是最核心的考量之一。对于处理敏感信息(如医疗记录、金融数据、专有商业信息)的应用,将数据发送给第三方 API 存在不可接受的风险。私有化部署能确保数据保留在企业可控的范围内。

- 定制化与微调 (Fine-tuning): 开源模型允许企业使用自己的专有数据进行微调,使其更适应特定行业、领域或任务,获得比通用 API 更好的效果。

- 成本控制 (特定场景下): 对于 API 调用量极大的应用场景,长期来看,一次性的硬件投入和运维成本可能低于持续支付的高额 API 调用费用。

- 延迟控制: 将模型部署在靠近用户的边缘服务器或本地数据中心,可以显著降低网络延迟,提升实时交互应用的体验。

- 离线可用性: 在无法稳定访问互联网的环境下,本地部署是唯一选择。

- 满足合规要求: 某些行业或地区的法规可能要求数据处理必须在本地进行。

选择合适的开源 LLM:大小决定命运

在规划私有化部署时,选择哪个(以及多大参数规模的)开源 LLM 是第一步,也直接决定了后续的硬件投入。目前主流的开源 LLM 按参数规模大致可分为:

- 小型模型 (Small, ~3B-8B 参数): 例如 Meta 的

Llama 3 8B, Mistral AI 的Mistral 7B, Microsoft 的Phi-2/Phi-3 Mini。这类模型在推理时对硬件要求相对较低,通常可以在一块高端消费级 GPU 上运行,是私有化部署的入门选择。 - 中型模型 (Medium, ~13B-40B 参数): 例如

Llama 2 13B, 阿里巴巴的Qwen 14B。性能通常优于小型模型,但对 GPU 显存 (VRAM) 的要求显著提高,往往需要 24GB 或更高显存的 GPU。 - 大型模型 (Large, 70B+ 参数): 例如

Llama 3 70B, Mistral AI 的Mixtral 8x7B(这是一个混合专家模型,总参数量更大但激活参数约 13B),Qwen 72B。这类模型的性能非常强大,接近甚至超越某些版本的 GPT-3.5/GPT-4,但对硬件的要求也呈指数级增长。推理通常需要多块高端 GPU(消费级或数据中心级),而微调则几乎必须依赖强大的多 GPU 服务器集群。

关键权衡: 模型参数量越大,通常意味着更强的理解、推理和生成能力,但同时也需要更多的计算资源(尤其是 GPU 显存)和更长的处理时间。

量化技术 (Quantization): 为了让大型模型能在资源有限的硬件上运行,社区发展出了量化技术(如 4-bit, 8-bit 量化)。它通过降低模型参数的数值精度(例如从 16 位浮点数降到 4 位整数)来大幅减少模型大小和显存占用,通常只带来轻微的性能损失(有时甚至没有)。这使得在消费级硬件上运行中大型模型成为可能,是私有化部署的关键推动力之一。

核心挑战一:高昂的硬件服务器成本

这是私有化部署最直接、最显性的门槛。

LLM 推理 (Inference) 服务器成本

即使只是运行模型进行推理(不涉及训练),硬件成本也可能很高。

- GPU 显存 (VRAM) 是最大瓶颈: 模型的所有参数(权重)必须能够完全加载到 GPU 显存中才能高效运行。显存需求大致估算如下(实际需求受量化方式、上下文长度、批处理大小等多种因素影响):

- 7B 模型 (FP16/BF16): 大约需要 14GB+ 显存。

- 7B 模型 (4-bit 量化): 大约需要 5GB – 8GB+ 显存。

- 13B 模型 (FP16/BF16): 大约需要 26GB+ 显存。

- 13B 模型 (4-bit 量化): 大约需要 8GB – 10GB+ 显存。

- 70B 模型 (FP16/BF16): 大约需要 140GB+ 显存(必须多卡)。

- 70B 模型 (4-bit 量化): 大约需要 40GB – 50GB+ 显存(可能需要一块超大显存卡或两块高端卡)。

- GPU 选择与成本:

- 运行 7B/13B (量化后): 在拥有 24GB VRAM 的高端消费级 GPU (如

RTX 3090,RTX 4090) 或 48GB VRAM 的专业卡 (RTX 6000 Ada) 上是完全可行的。构建这样一台服务器的成本可能在几千到一两万美元之间。 - 运行 70B (量化后): 需要单卡显存 >40GB,可选方案包括

RTX 6000 Ada (48GB),或者数据中心级的A100 (80GB),H100 (80GB)。如果需要运行 FP16 的 70B 模型,则几乎必须使用多块A100/H100并通过 NVLink 连接。这样一台服务器的成本将轻松达到数万甚至十几万美元。

- 运行 7B/13B (量化后): 在拥有 24GB VRAM 的高端消费级 GPU (如

- CPU & RAM: 虽然不像 GPU VRAM 那样是硬性瓶颈,但也需要足够强大来处理数据加载、请求分发等任务。建议选择具有较多核心数(如 16+)和高 PCIe 带宽的 CPU,并配备充足的 RAM(如 64GB – 128GB 或更多,取决于模型加载和并发需求)。

- 存储: 需要高速 SSD(最好是 NVMe)来快速加载动辄几十 GB 的模型文件。容量需求取决于您计划部署的模型数量。

LLM 微调 (Fine-tuning) 服务器成本

如果您的目标是使用自有数据对 LLM 进行微调,那么硬件成本将**急剧上升**。

- VRAM 需求激增: 微调不仅要加载模型权重,还要存储梯度信息、优化器状态(如 Adam 优化器的状态是模型参数量的两倍)等。通常,微调所需的显存可能是同等精度下推理需求的 2 到 4 倍甚至更多。这意味着即使是中等大小的模型(如 13B)进行全参数微调,也可能需要多块拥有超大显存的 GPU。

- 计算需求高: 微调过程涉及反复的正向和反向传播计算,需要强大的 Tensor Core 性能,耗时也远超推理。

- 硬件配置: 对中大型模型进行微调,几乎不可避免地需要配备**多块高端数据中心 GPU(如 A100/H100)** 并通过 **NVLink** 高速互联的服务器或集群。单台这样的服务器成本就可能高达数十万美元。

- PEFT (参数高效微调): 像 LoRA (Low-Rank Adaptation) 这样的技术可以只训练模型中一小部分(新增的)参数,从而**显著降低**微调所需的 VRAM 和计算量。这使得在单块或少数几块高端消费级/专业级 GPU 上微调大型模型成为可能,大大降低了门槛,但仍然是对硬件的严峻考验。

核心挑战二:软件、部署与运维的复杂性

硬件成本只是冰山一角,软件、部署和长期运维的挑战同样巨大。

软件栈与部署

- 推理服务框架: 需要选择并部署合适的推理服务框架,如 Hugging Face 的 TGI (Text Generation Inference), vLLM, NVIDIA Triton Inference Server, 或 Ollama 等。这些框架能优化模型加载、批处理请求、提高并发性能,但配置和优化它们本身就需要专业知识。

- 环境与依赖管理: 需要搭建包含正确版本 Python、CUDA、PyTorch/TensorFlow 等依赖的运行环境,管理复杂依赖关系可能很棘手。

- 微调框架: 需要使用 Hugging Face Transformers, PEFT, Accelerate 等库,对于大规模模型可能还需要 DeepSpeed, Megatron-LM 等分布式训练框架,使用门槛较高。

- 应用集成: 将本地部署的 LLM API 集成到现有的业务系统或应用中,需要额外的软件开发工作。

运维成本与挑战

- 电力与散热: 运行多块高功耗 GPU 的服务器是名副其实的“电费刺客”,需要考虑持续的电力成本和数据中心的散热能力。

- 维护与更新: 需要定期维护服务器硬件,更新操作系统、驱动程序、CUDA、Python 库以及 LLM 模型本身。

- 专业技能 (MLOps/DevOps): 成功部署和运维私有 LLM 需要一支具备 MLOps(机器学习运维)、DevOps、基础设施管理甚至 AI 模型优化经验的团队。这类人才是目前市场上的稀缺资源,人力成本高昂。

- 安全与合规: 即使是私有化部署,也需要建立完善的安全防护体系(网络隔离、访问控制、数据加密等)和数据治理策略,确保符合相关法规。

- 扩展性: 如果业务增长导致并发请求增加,如何平滑地扩展私有部署的 LLM 服务(增加更多服务器、负载均衡、优化服务架构)是一个复杂的技术和成本挑战。

私有化部署 vs. Cloud API:成本与价值权衡

那么,到底应该选择私有化部署还是使用 Cloud API 呢?这需要仔细权衡:

Cloud API (如 OpenAI, Anthropic, Google Vertex AI):

- 优点: 接入简单快捷,无需关心硬件和运维,按需付费(理论上),通常能用到更大、更先进的模型,具备良好的可扩展性。

- 缺点: 数据隐私是最大顾虑,供应商锁定风险,大规模使用时成本可能非常高昂,可能遇到速率限制,定制化能力有限。

私有化部署:

- 优点: 数据完全可控,安全性高,可以针对特定业务进行深度定制和微调,无 API 调用限制,对于超大规模、高频次调用场景,长期 TCO 可能更低。

- 缺点: 极高的初始硬件投入,复杂的部署和运维过程,需要专业的 MLOps/DevOps 团队支持,持续的电力/散热/维护成本,模型能力可能落后于闭源 SOTA 模型(除非部署顶级开源模型)。

最终的选择取决于您的具体业务需求:数据敏感性有多高?应用规模有多大?是否需要深度定制?预算有多少?内部技术实力如何?

结论:机遇与挑战并存

得益于开源社区的蓬勃发展和量化等技术的进步,在本地或私有云中运行强大的大语言模型(LLM)正变得越来越可行,尤其对于中小型模型而言。这为企业和个人带来了前所未有的数据掌控力、定制化潜力和应用创新机遇。

然而,我们必须清醒地认识到,“免费”的开源模型并不意味着“零成本”的部署。高昂的硬件(特别是 GPU)投入、复杂的软件配置与集成、持续的运维成本(电力、散热、人力)以及对专业技能的依赖,都是摆在面前的巨大挑战。在决定走上私有化部署之路前,务必进行审慎的评估,全面考量其成本、风险以及与使用 Cloud API 相比的真正价值所在。