-

VPS与云服务器深度对比:2026年创业团队该如何选?

别被名字骗了,VPS和云服务器的本质差距可能比你想象的更大——也可能更小。 朋友,如果你正打算为创业项目挑一台服务器,大概率会在VPS和云服务器之间纠结。网上那些对比文章,不是照着维基百科念定义,就是云厂商写的软文。今天咱们抛开那些套话,站在2026年的十字路口,重新审视这两个选项:它们到底差在哪?创业团队的钱该往哪砸? 我不会告诉你“云服务器就是未来的趋势”——这种话2026年还在说,就像告诉别…...- 0

- 0

- 2

-

边缘计算的“神经系统”:如何构建可伸缩的云边协同运维体系?

一个工厂的自动化产线突然与云端失联,但机器臂仍在精准焊接——这不是奇迹,而是边缘自治的功劳。可问题是,当网络恢复时,那台机器臂的三个小时生产数据,该如何与云端无缝对账? 去年参观一家新能源电池工厂,他们的CIO给我看了一个监控大屏:两千多个边缘节点分布在全国七个生产基地,从PLC到智能相机,从AGV到环境传感器。屏幕上的绿色圆点代表在线,红色代表离线。最让我惊讶的是,离线率常年保持在15%左右,但…...- 0

- 0

- 39

-

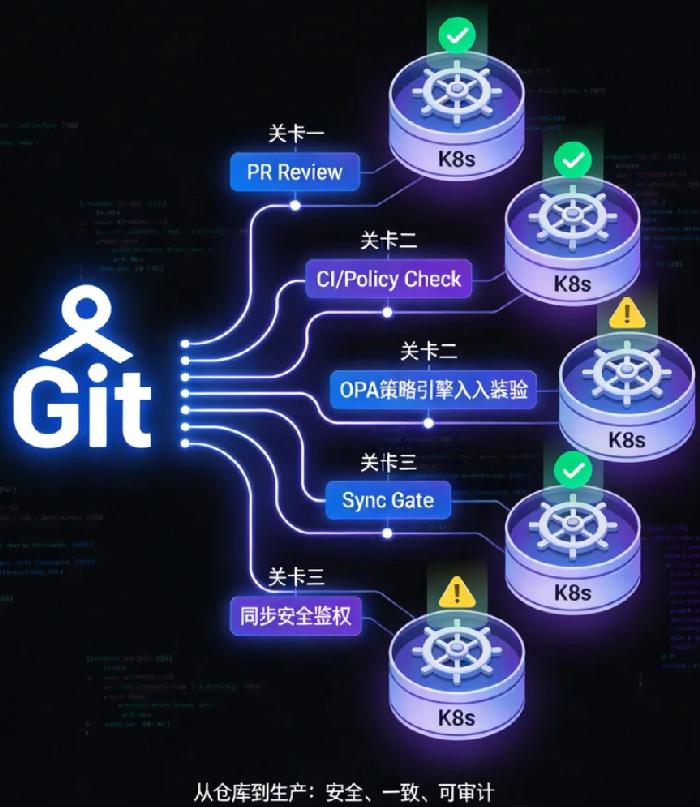

从仓库到生产:GitOps在多集群环境下的安全交付与一致性保障

当你的集群数量超过两位数,每一次配置变更都像在雷区里跳舞——这边刚修复一个环境的镜像标签,那边的审计发现配置又漂移了;昨天还在用的部署方式,今天因为权限模型不同而失效。GitOps的承诺是“声明式交付”,但多集群的现实是“异构迷宫”。 上个月和一个管理着80个Kubernetes集群的朋友聊天,他给我看了一张截图:ArgoCD的界面里,同一个应用的配置在五个环境里呈现出五种不同的状态——不是因为故…...- 0

- 0

- 37

-

成本感知调度:如何让Kubernetes在满足SLO的同时主动优化云账单?

你的集群看起来“健康”——节点利用率80%,没有pending的Pod,没有报错。但你不知道的是,那80%里有一半是被“请求值”锁死的空气,而账单上的数字,正在为这些看不见的空气默默买单。 上个月和一个做FinOps的朋友喝酒,他给我看了一组数据:他们分析了100个生产集群后发现,平均每个集群有30%-40%的已分配资源从未被实际使用。这些资源被Kubernetes“预留”了,但它们只是躺在那里,…...- 0

- 0

- 44

-

安全策略的“热更新”:如何在不停机的情况下动态加固云原生环境?

我们都在生产环境遇到过这种两难:一个高危漏洞曝出,补丁已经就绪,但重启意味着中断SLO;而不重启,漏洞就像悬在头顶的剑。在云原生环境里,这种“补丁重启”与“系统韧性”的冲突,正在成为安全团队最头疼的零和博弈。 上周和一个做安全平台的朋友聊到凌晨两点。他给我看了一组数据:他们追踪的300家企业里,超过60%的严重漏洞利用事件,发生在补丁发布后的72小时内——不是因为企业不重视,而是因为“没排上重启窗…...- 0

- 0

- 51

-

Serverless混沌工程:在“黑盒”中验证韧性的三种实验范式

我们习惯了在Kubernetes里随意kill一个Pod、给网卡增加几百毫秒延迟、让磁盘IO飙到100%。这些对基础设施的“暴力测试”,到了Serverless环境全失效了——因为你根本不知道Pod跑在哪里,也碰不到那张网卡。当函数即服务的黑盒关上舱门,我们该如何验证它到底有多抗揍? 这个问题我过去三个月被问了不下二十次。 不是来自刚刚接触Lambda的新手,而是那些已经在生产环境跑了上百个函数、…...- 0

- 0

- 74

-

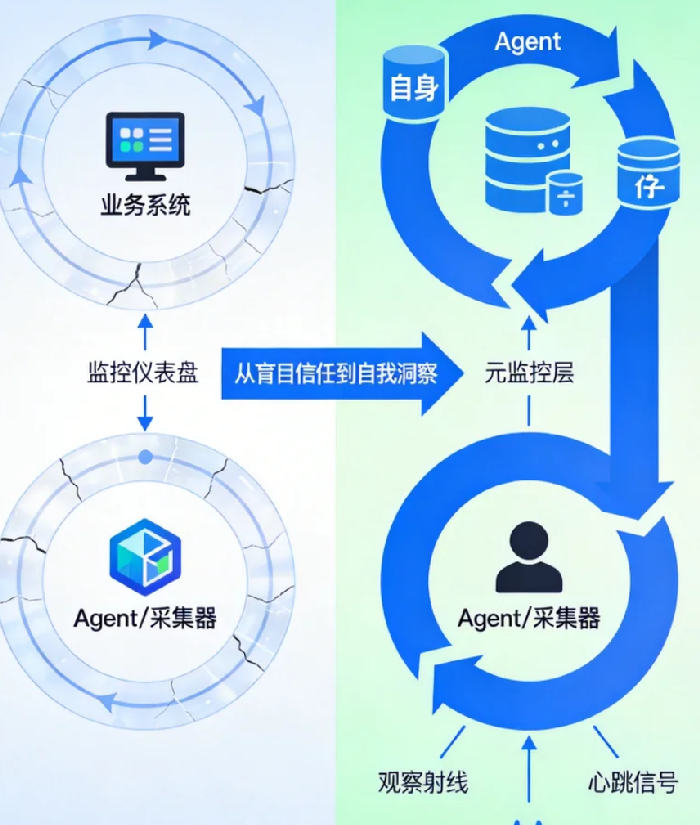

可观测性的“第一公里”问题:当数据源头本身不可观测时

一个完美的监控仪表盘,背后是三个已经静默失效的数据采集Agent——我们最信赖的“眼睛”,在最需要它们的时候,选择了集体失明。 凌晨三点,你被一阵急促的电话铃声惊醒。业务部门投诉核心交易链路出现大面积失败,而你面前的监控大屏却一片祥和——所有曲线平稳,指标绿色,宛如数字世界的伊甸园。你本能地刷新页面、检查网络、重启监控服务,但绿意依旧。直到半小时后,你偶然登录到其中一台服务器手动检查,才发现那个负…...- 0

- 0

- 69

-

图谱的“数据契约”:如何治理与验证流入运维知识图谱的数据质量?

一次本应被知识图谱预警的级联故障悄然发生,而图谱却显示一片宁静——只因提供核心依赖关系的数据源,其更新延迟了宝贵的30分钟。 深夜,订单系统因一个下游库存服务的异常开始出现间歇性失败。你的“智能运维大脑”——那个耗费数月构建的、具备“热加载”能力的知识图谱——正基于数据勤奋地推理。然而,它给出的结论却是:“订单服务自身健康,网络链路无异常,建议检查近期代码变更。” 团队据此徒劳地排查了两个小时。 …...- 0

- 0

- 78

-

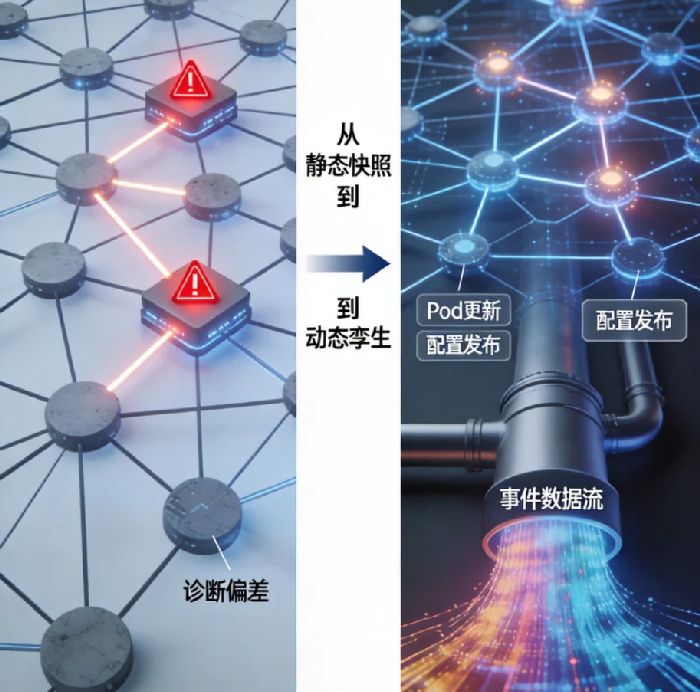

知识图谱的“热加载”:如何实现运维知识的分钟级更新与反向验证?

一份精心绘制的城市地图,在发布那一刻就已开始过时——新路开通、旧桥维修、单行道调整,而运维知识图谱面临的困境,远比这严重百倍。 凌晨两点,一次常规的数据库索引变更后,订单服务的响应时间莫名其妙地增加了30毫秒。你的“智能诊断系统”基于一周前构建的知识图谱忙碌地分析着,它认真排查了服务链路、网络拓扑,甚至翻看了最近的错误日志,最终给出一个令人哭笑不得的结论:“怀疑是宿主机底层虚拟化性能抖动,建议重启…...- 0

- 0

- 69

-

诊断智能:超越监控面板,构建AI原生的“系统认知图谱”

凌晨三点,一个由五十个微服务组成的订单系统出现性能抖动。您的监控大屏上,十三个不同颜色的指标同时告警,而一个真正的“系统认知图谱”早已在无声中绘制出故障的完整传播链路,并指向了根源——一个八小时前部署的、看似无关的营销服务缓存配置。 深夜,当你被一连串刺耳的告警惊醒,面对满屏飘红的指标时,是否有过这样的无力感:我们拥有前所未有的数据,却依然对系统的“病情”一知半解。CPU、内存、延迟……这些数字如…...- 0

- 0

- 86