本文不玩概念、不卖焦虑,只解决问题。你打算部署私有GPU服务器?好,那就告诉你实打实的干货:哪张卡能跑Qwen?需要多大内存才能稳定微调LLaMA?是否必须上H100?你能在预算范围内实现推理、训练、平台管理吗?我们按需推荐配置,按模型核算资源,给出具体组合与部署技巧。没有一堆废话,只有能落地的技术方案。

目标驱动型部署思维:你不是买卡,是建战场

GPU部署不是装机,而是按任务设计“算力武器”。先明确用途,再决定架构:

| 用途 | 典型模型 | 显存需求 | 建议 GPU |

|---|---|---|---|

| 大模型推理 | Qwen1.5-14B, LLaMA2-13B | ≥48GB | RTX 6000 Ada / A40 |

| LoRA 微调 | Baichuan2-7B LoRA | ≥80GB(多卡) | A100 PCIe ×2 |

| MLOps测试平台 | 多模型并发 | ≥24GB × 多 | RTX 4090 + A5000 混插 |

推荐三套实战配置组合(附单价)

🚀 入门部署型(预算友好)

- GPU:RTX 4090 24GB ×1(¥11,000 二手)

- CPU:Intel Xeon Silver 4310(¥2,800)

- 主板:Supermicro X12 系列,支持PCIe 4.0

- 内存:128GB ECC DDR4

- 系统盘:1TB NVMe + 2TB SATA

支持推理 Qwen 7B/13B(量化版),可挂载 HF 模型本地部署,支持 bitsandbytes。

🔥 专业训练型(中型团队)

- GPU:A100 80GB PCIe ×2(¥28,000×2)

- CPU:AMD EPYC 7313P(¥5,000)

- 主板:Supermicro H12SSL

- 内存:512GB DDR4 ECC

- 电源:2000W 冗余热插拔模块

支持完整模型训练,LoRA微调、QLoRA、自定义脚本无压力,配合 NCCL 通信。

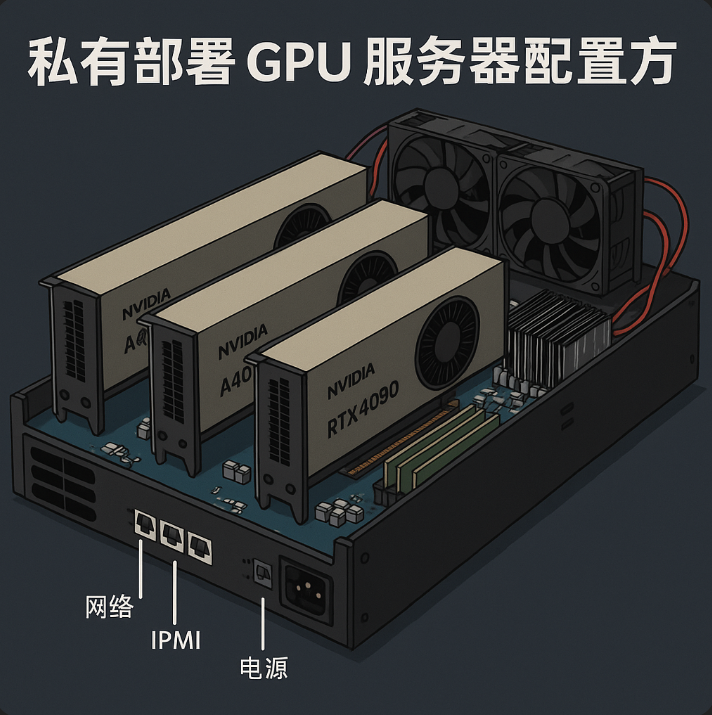

🧠 混合研发型(云边结合)

- GPU:RTX A6000(48GB)+ A40(48GB)

- 主板:支持多GPU隔离 + IPMI 管理

- 网络:万兆光口,搭配私有交换机

支持 Dev + Ops 混合部署场景。模型压测、分流推理、性能监控等一体化。

从零部署 HuggingFace 大模型:实操流程

下载模型:

git lfs install

huggingface-cli login

git clone https://huggingface.co/Qwen/Qwen1.5-14B-Chat

运行环境搭建:

conda create -n llm python=3.10

conda activate llm

pip install torch transformers accelerate bitsandbytes

运行推理服务(以vLLM为例):

pip install vllm

python3 -m vllm.entrypoints.openai.api_server \

--model Qwen/Qwen1.5-14B-Chat \

--tokenizer hf-internal-testing/llama-tokenizer \

--tensor-parallel-size 1

GPU服务器的热维护建议(进阶)

- 监控系统:Prometheus + Node Exporter + nvidia-smi-exporter

- 硬件健康监控:IPMI Sensor 定期抓取温度、电流、电压

- 推理性能压测:Locust + wrk / ab 工具组合

- 模型版本控制:Git + DVC,支持多版本/快照部署

常见GPU服务器部署误区

- 以为装得上就能跑满 → PCIe 速率不够,瓶颈严重

- 忽略机房进风量与风道 → 显卡自动降频你都不知道

- 默认全栈root运行 → 安全隐患极大,建议容器隔离

可拓展架构:边缘算力 + 云集群

将本地GPU集群作为缓存节点/推理分流,训练仍由云完成。建议搭配如下结构:

- 本地:vLLM推理 + ArgoRollout

- 远程:S3/OSS 文件存储,模型热同步

- 统一:Traefik API 网关 + OAuth2 认证

结尾

部署GPU不是“尝鲜”,而是“节流 + 自由 + 性能”。只有理解每一张卡的价值、每一条总线的带宽、每一块板的功耗,才能构建真正属于你的算力体系。