你有没有遇到过这种情况:Docker 容器明明都跑得好好的,但服务器磁盘、内存却悄悄见底,top 一看,负载炸了、系统吃紧,但 ps aux 找不到罪魁祸首。你甚至怀疑是不是被挖矿了……但其实,这锅很可能得让一群“死而不僵”的 Zombie 容器背。

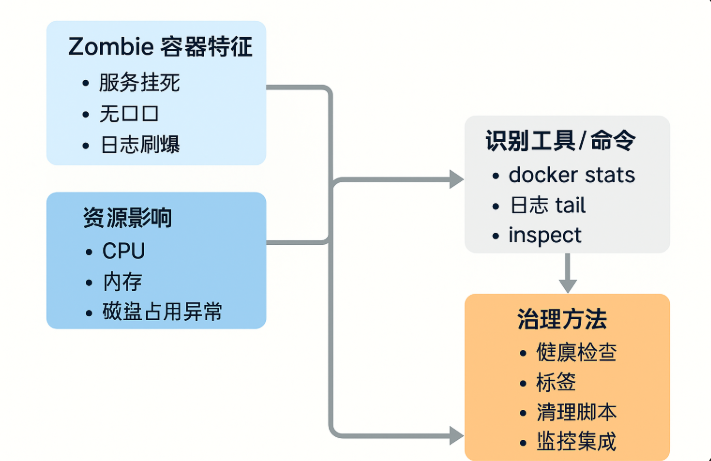

Zombie 容器,这个词听起来像 B 级片的标题,但它在你的服务器上可能早已横行多年。它们悄无声息地消耗着资源,不暴露端口、不报错,日志也少得可怜,却始终占着 CPU、内存和磁盘的坑。

这篇文章我们就来掰开了揉碎了说清楚:什么是 Zombie 容器,它们是怎么变成 Zombie 的,为什么你根本发现不了,以及——如何真正清理它们。

Zombie 容器到底是什么鬼?

Zombie 容器 ≠ exited 状态的容器,也不等于“run 失败的容器”。它们的本质是:

- 看似还在运行(

docker ps可见),但实际上已经没有业务作用; - 不再响应请求(端口断开或服务僵死);

- 长期不被管理、不被监控覆盖;

- 默默吃内存、撑磁盘,有的还疯狂刷日志或者丢异常。

它们可能是某个服务进程挂了但容器本身还在、也可能是日志写爆了却没配置轮转、甚至是你早就忘了哪个 cron job 启动的 worker 没关。

你不主动排查,它们就永远在你资源后备箱里“躺尸”。

为什么会有 Zombie 容器?这些锅你可能早背了:

- 服务挂了但容器没崩: 某个 NodeJS、Python、Java 服务挂了,但主进程没退出,容器就还在那假装活着。

- 健康检查没配置或失效: 没有 liveness/readiness probe,服务死了没人通知你。

- 运维流程不规范: 拉起测试容器后没删,脚本异常导致容器泄漏,CI/CD 没做自动清理。

- 日志/缓存撑爆系统: 某些容器长时间运行、未做日志分割,占满磁盘空间。

- 镜像或进程错误导致容器不报错但功能废了: 最可怕的一类,程序自以为跑着,实际所有功能不可用。

Zombie 容器的危害有多大?别等它拖垮你的生产系统

- 占用系统资源:内存、磁盘、文件句柄、网络连接,统统都占。

- 影响监控准确性:你明明指标很差,但容器“看起来没事”,简直是监控系统的盲区。

- 导致运维误判:你排查半天都没看到问题,直到最后才发现 Zombie 才是元凶。

- 影响调度与扩容策略:K8s、Swarm 等编排系统会误判节点可用性,容器调度错乱。

Zombie 容器就像一间废弃但还在供电供暖的空办公室,每天都在烧钱,你却不知道它还开着灯。

如何发现 Zombie 容器?别只靠 docker ps

常规手段 docker ps、docker stats 能看到容器运行情况,但 Zombie 容器往往“跑得慢、吃得多、啥也不干”。所以要结合多个视角排查:

🔍 容器资源使用异常

docker stats --no-stream找出 CPU 占用持续为 0% 或 MEM 占用异常高的容器。

🧟 非活跃连接与空服务

docker inspect <container_id> | grep -i "exposedports"没有对外端口或连接活跃度低的服务,基本就有 Zombie 嫌疑。

🔁 日志写入无效 or 异常多

docker logs <container_id> | tail -n 100长期报错、日志重复堆积、没有任何访问日志?可能这个服务早就没人用了。

⚙️ 脚本检测工具(推荐自建)

定期遍历所有容器运行状态 + 网络连接 + 日志输出,打分标记 Zombie 概率。

如何治理 Zombie 容器:别只想着 prune,那只是擦桌布

大多数人一看到容器占用多就用:

docker container prune对不起,这个命令只清理 exited 容器,对 Zombie 一点用都没有。

✅ 正确姿势:

1. 用 tags/label 标注业务容器

在部署脚本或 CI/CD 中加上 label,方便区分用途

docker run -d --label purpose=prod nginx2. 加入监控系统

- Prometheus + cAdvisor + Grafana

- Loki + Grafana 查看异常日志

3. 设置自动健康检查

healthcheck:

test: ["CMD", "curl", "-f", "http://localhost"]

interval: 30s

timeout: 10s

retries: 3挂了就能报警,容器还能自动重启。

4. 定时 Zombie 检测脚本

每日定时扫一遍低活跃容器,打报告通知

0 2 * * * /opt/scripts/zombie-check.sh >> /var/log/zombie.log5. 容器编排:K8s + Probes + TTL controller

把生命周期交给控制器管理,避免 Zombie 滋生。

实战案例:一次磁盘爆满的背后竟然是 47 个 Zombie 容器

某次用户投诉网站突然响应变慢,查看服务器发现磁盘空间剩下不到 5%。最初以为是日志未归档,但排查后发现并非日志暴涨。

进一步检查 docker 容器发现:

docker ps -a | wc -l # 结果是 112而线上实际只部署了 60 个容器服务!

继续用 docker stats 和 logs 检查,发现一批历史遗留的测试容器未关闭,其中一半已无响应,仅靠 base 镜像运行,疯狂写标准输出的垃圾数据。

清理后服务器负载恢复正常,磁盘使用率从 97% 降至 68%。

Zombie 容器永远不会“自动死”,但你可以让它们“被安排走”

Zombie 不可怕,可怕的是你不知道它们藏在哪、不知道怎么清理、更不知道它们已经把你服务器拖慢。

别再迷信容器化就代表“自动化”,也别指望 docker 自己能打扫干净战场。容器就像房客,搬进来了之后你得定期检查卫生、查水表。

Zombie 容器清理,是每个运维必须养成的“洁癖”。

养成定期监控 + 检测 + 标记的习惯,让你的服务像新装修的办公室一样干净、高效、没有暗角藏尸体。

因为运维的噩梦,往往就埋在这些你看不到的角落里。