你有没有碰到过这种情况:系统 QPS 不高、网络看着没掉、服务日志也没爆红,结果业务端用户抱怨访问巨慢,甚至页面空白。你刷新 Grafana,网络丢包率 0%,CPU 内存也正常,但延迟图谱就像过山车。那种“明明一切都好却慢得要命”的场景,往往不是偶发 bug,而是你没注意到一个关键幕后元凶 —— TCP 队头阻塞(Head-of-Line Blocking)。

这个问题并不新,但在高并发、复杂链路的系统里,它是一种不易察觉、却极其致命的慢性病。今天我们就来聊聊它的本质、诱因、危害、排查方法和实战优化路径。

什么是 TCP 队头阻塞?别被名字糊弄了

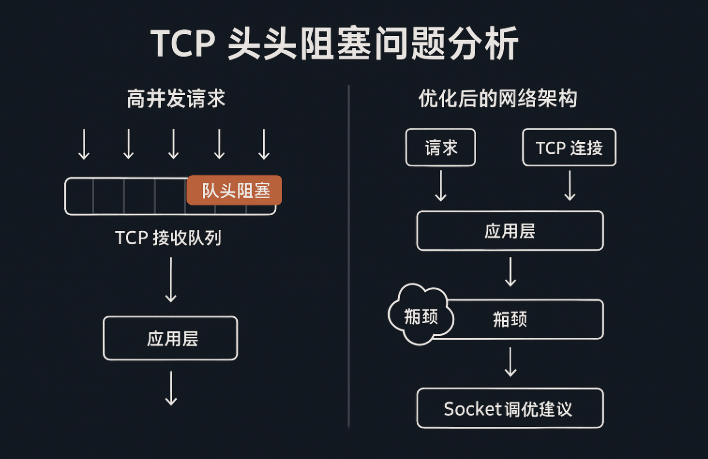

TCP 队头阻塞,其实就是“前面那包数据没处理完,后面所有包都得乖乖等着”。

想象你在快递分拣中心,有一大堆包裹排队。只要前面那个地址模糊不清的包裹还没搞定,后面的包裹一个都发不出去。即便后面有些包特别急、特别重要,也一样被卡在后面。TCP 做的就是这么“讲秩序”。

为什么会这样?因为 TCP 是个 可靠、按序、流控制的协议。它保证字节流“顺序正确”,你先发的先收到。如果中间某个包丢了、乱序了,接收方就得等这个包“复原”后再往上传递应用层。否则就不能解包,不然业务逻辑会一团乱麻。

这就是队头阻塞的由来:某一个包出了问题,整个后续传输全部卡住。

高并发环境下,为什么更容易触发队头阻塞?

你可能会问:TCP 是几十年前设计的协议,为什么今天它的问题却更严重了?

因为我们的场景变了。

现代系统都是“微服务 + 多链路 + 高并发 + 海量连接”,每一次用户操作背后,可能触发数十个 TCP 请求串联起来,一旦其中任何一条链路出现队头阻塞,整个响应链路都被连坐影响。

以下是几个高发场景:

1. 网络抖动 + 丢包:TCP 必须重传,延迟大增

如果某个链路在高峰期出现丢包(哪怕只有 0.5%),TCP 的重传机制就会触发。而 TCP 的重传间隔是指数回退的。第 1 次丢包等 1 秒,第 2 次等 2 秒……你以为是个小问题,用户可能已经转身关掉页面。

关键点:即使只是一个包丢了,后面的所有包都会被“堵车”。

2. 单连接内混合请求,导致业务响应串行阻塞

假设你在一个 TCP 连接里发了多个请求(比如 HTTP/1.1 的复用场景),结果第一个请求处理缓慢,后面的请求即便可以快速响应,也只能等。客户端收不到完整响应,页面加载一片空白。

这就是为什么 HTTP/2 推出时解决了一部分队头阻塞的问题,而到了 HTTP/3(基于 QUIC)才真正绕开了 TCP 的限制。

3. Nagle 算法 + 延迟确认(Delayed ACK)组合拳

你在优化 TCP 性能时,有没有遇到过 tcp_nodelay 参数?它就是为了绕开 Nagle 算法引发的队头阻塞问题。这个算法试图“合并小包”,但如果客户端不及时 ACK,服务端就死等,整个请求迟迟发不出去。

TCP 队头阻塞带来的危害,你可能低估了

你以为它只是“慢一点”?不,它的蝴蝶效应可以把整个系统拖入雪崩:

☠️ 表现一:延迟暴涨 + 报警风暴

监控系统发现响应时间异常拉高,所有服务开始报警,根源却只是一两个 TCP 连接里卡了个包。

☠️ 表现二:业务雪崩 + 用户流失

高并发时,如果存在几个队头阻塞的连接,可能瞬间影响上千个请求延迟,导致用户操作失败、订单提交不了、支付失败。尤其是在电商、金融系统里,这等于直接“烧钱”。

☠️ 表现三:系统资源异常消耗

延迟拉高会让连接占用时间变长,线程堆积、资源被锁住,最终出现线程池耗尽、GC 频繁、内存爆炸等一系列“连锁反应”。

怎么判断是 TCP 队头阻塞导致的?

这个问题最难的地方就是:你看不到它直接“抛异常”。

但可以通过以下几种方式进行间接判断:

✅ 1. 抓包分析:看 TCP Reassembly 行为

使用 Wireshark 或 tcpdump 抓包,观察是否存在大量乱序或重传,尤其是有包“迟迟未确认”,后续包积压严重。

✅ 2. 接入应用层请求链路跟踪

比如 Jaeger、SkyWalking,发现某些链路上游耗时正常,但中间跳点突然延迟暴涨,可能就是队头阻塞在作祟。

✅ 3. 看 SYN-ACK/ACK RTT 与数据包 RTT 差距

如果握手 RTT 仅几十毫秒,但后续数据传输 RTT 高达几百毫秒以上,且时常抖动,可初步判断存在阻塞现象。

✅ 4. 大量突发性连接超时或业务接口 TPS 急剧下降

没有资源瓶颈、没有 CPU 打满、没有数据库卡顿,却业务请求响应暴跌,十有八九是网络传输上出了问题。

如何缓解 TCP 队头阻塞问题?

TCP 本身不能绕过按序传输的机制,但我们可以通过“分散、分流、并发、协议升级”等方式规避它。

✅ 1. 升级协议,能上 HTTP/3 就别继续 HTTP/1.1

HTTP/3 基于 UDP + QUIC,天然支持多路并发,每个流独立,不再受到 TCP 队头阻塞的影响。

对内网服务或用户端产品,可以考虑逐步切换。

✅ 2. 关闭 Nagle 算法,开启 TCP_NODELAY

尤其是 RPC 框架、游戏服务器等小包多的系统,开启 TCP_NODELAY 可以让小包不被聚合,避免因延迟确认等待而卡住传输。

bashsetsockopt(socket_fd, IPPROTO_TCP, TCP_NODELAY, &flag, sizeof(int));

✅ 3. 限制连接单一长链路请求数,避免串行积压

将请求在多个连接中分散,降低一个连接卡顿带来的全局连锁反应。例如配置 Nginx 与后端之间的连接池数量合理提升,并发压力分摊。

✅ 4. 建立业务级心跳探测与请求超时控制

不要完全依赖 TCP 的重传机制,应用层要有“业务 ACK”与定时中止策略,一旦等待超时立即中止请求,释放资源。

✅ 5. 监控链路质量指标,建立异常探测策略

通过链路 RTT、乱序率、重传率等指标进行持续监控,一旦发现某连接表现异常即切换备用链路或做降级处理。

实战案例分享:如何通过分析队头阻塞恢复业务

某 SaaS 平台某次高峰期用户投诉系统频繁超时,API 网关监控全绿,但前端请求延迟均值高达 800ms。最终运维团队通过如下手段定位:

- 抓包发现部分连接存在 6 秒以上无响应;

- Prometheus 中

node_network_transmit_errs_total突然增高; - 网络链路上存在轻微丢包,触发 TCP 重传;

- 连接池复用过度,导致部分连接卡住影响多个请求;

最终通过:

- 增加连接池大小

- 设置请求最大超时控制

- 升级后端 RPC 框架使用 HTTP/2

恢复系统性能,并将延迟稳定控制在 150ms 内。

最后,说句真心话

TCP 是伟大的协议,但它并不是为今天这种万级并发、多链路依赖、业务实时性极高的互联网架构设计的。

你可以继续相信它的可靠传输,但你得警惕它带来的副作用,尤其是那颗随时可能引爆的“队头炸弹”。

别让一个小包卡死你一整套业务链条。真正的问题,不在你有没有监控 TCP,而是你有没有理解它运行的机制,以及那些“明明没错”的行为,其实正在摧毁你用户的耐心。

现在,是时候把你的 TCP 盲点补起来了。