凌晨两点,你的手机突然响起刺耳的警报——网站挂了。打开电脑一看,满屏的502 Bad Gateway,像一道红色警报刺穿你的视网膜。上周那个电商团队就经历了这样的惊魂夜,大促活动刚开始十分钟,整个网站就被502错误淹没,技术总监急得差点把键盘砸了。

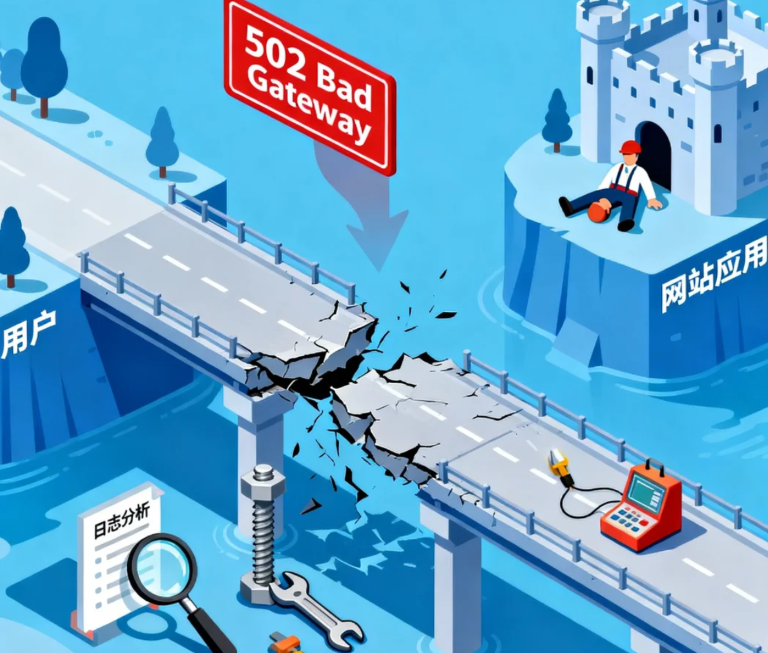

502错误就像数字世界的“停电事故”。灯为什么不亮?可能是保险丝烧了,可能是发电站故障,也可能是整个城市的电网崩溃。

第一阶段:紧急定位——找到“停电区域”

别急着重启服务器,那就像停电时盲目地去推电闸。先打开你的错误日志,那里记录着事故发生的第一个线索。

在Nginx日志中,看到”upstream timed out”意味着后端服务响应超时——你的请求在门口等得太久,网关直接关门了。发现”Connection refused”说明网关根本找不到后端服务——就像按门铃时发现整栋楼都空无一人。”upstream sent invalid header”则暗示后端返回了错误格式的数据——好比收件人寄来一封完全看不懂的外星文书信。

那个电商团队最初以为是数据库问题,查了半小时才发现是PHP-FPM进程全部卡死。“我们像无头苍蝇一样到处乱查,最后才发现问题就在最明显的地方”,技术负责人事后反思。

第二阶段:深入排查——检查“供电链路”

现在你需要像个电工一样,逐段检查整个“供电系统”。

检查PHP-FPM进程池:你的进程是不是像周末的网红餐厅,外面排着长队,里面座位却不够?运行sudo systemctl status php-fpm查看服务状态,用sudo netstat -tulpn | grep :9000确认监听端口,通过ps aux | grep php-fpm统计实际工作进程数。

有个新闻网站曾经因为PHP-FPM的max_children设置过低,流量稍大就出现502。调整这个参数后,错误率从15%直接降到零。

检查资源瓶颈:内存用尽时,系统会开始“拉闸限电”——随机终止进程来保全整体。用free -h查看内存使用,确保可用内存大于10%。磁盘满了的话,连写日志都会失败——df -h能告诉你真相。CPU满载时,系统根本没空理会新请求——top命令帮你找到消耗资源的元凶。

那个社交平台曾经每隔几天就出现502,最后发现是个隐藏的内存泄漏bug,PHP-FPM进程运行48小时后必定崩溃。“设置每天定时重启虽然粗糙,但确实解决了问题”,他们的运维工程师无奈地说。

第三阶段:网络层诊断——测试“输电线路”

网关和后端服务之间的网络,就像连接发电站和城市的输电线路。

检测端口连通性:在服务器上运行telnet 127.0.0.1 9000,如果连不上,说明PHP-FPM根本没在监听。查看防火墙规则:iptables -L可能会显示某个防火墙规则拦住了内部通信。

最诡异的一个案例是,某公司迁移服务器后频繁502,最后发现是安全组规则阻止了Nginx和PHP-FPM之间的通信。“我们检查了所有复杂配置,结果问题出在最基础的网络连通性上”,架构师苦笑着说。

第四阶段:应用层深挖——找出“短路设备”

有时候,问题不在基础设施,而在你的代码本身。

检查执行超时:某个API接口是否因为等待第三方服务而卡死?数据库查询是否缺少索引导致超时?文件操作是否因为权限问题一直挂起?

那个在线教育平台发现,他们的视频转码功能在处理某些特殊格式时会无限期挂起,最终拖垮整个PHP进程池。“我们给转码任务加了15分钟的超时限制,502错误就再也没出现过”,CTO分享了这个关键修复。

内存泄漏检测:使用pm.status_path监控PHP-FPM进程状态,发现那些持续增长的内存使用。有个WordPress站点因为某个插件的内存泄漏,每处理100个请求就必须重启进程。“找到那个问题插件并替换掉,比升级服务器配置管用多了”,站长这样总结。

当你下次面对502错误时,记住这个排查路径:从日志找到方向,检查进程状态,确认资源情况,测试网络连通,最后深挖应用代码。这套方法论比盲目重启能更有效地解决问题。

那个电商团队现在建立了一套完整的监控体系:PHP-FPM进程数、后端响应时间、服务状态码,任何指标异常都会提前告警。“我们现在能在用户感知到502之前就发现问题”,技术总监的语气中透着从容。毕竟,在运维的世界里,最好的故障处理永远是让故障根本不要发生。