凌晨两点,一家自动驾驶公司的数据湖告急——他们每晚需要处理的训练数据已突破30PB,而将如此规模的数据从欧洲的采集中心传输到北美的计算集群,仅仅完成传输就需要整整七天。这七天里,昂贵的GPU集群在静静等待,算法团队的工作完全停滞。

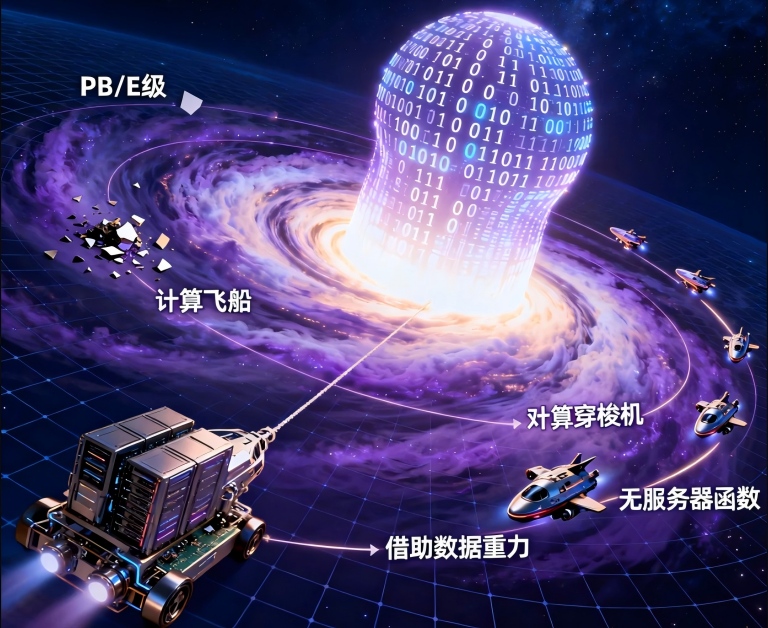

这不是带宽问题,也不是存储问题。这是一个关于 “数据重力” 如何开始主导技术决策的根本性转折。当你的数据规模从TB级跨越到PB级,再向EB级迈进时,一个无形的力场开始显现:数据变得如此之“重”,以至于移动它的成本超过了移动计算本身的成本;它的“引力”如此强大,开始将应用程序、计算资源乃至整个商业逻辑吸附到它的周围。

今天,我们不谈数据湖、数据仓库或流处理的具体技术选型,而是像老友围炉夜话,共同审视一个正在重塑我们所有架构假设的隐形力量:数据规模本身,如何从一个被动的处理对象,演变为一个主动的架构约束。

01 重新发现“数据重力”:一个被忽视的物理现实

“数据重力”不是营销术语,而是对一系列可观测物理现象的精炼隐喻。在物理学中,物体的质量会产生引力,吸引其他物体向它靠拢。在数字世界中,数据的规模(容量)、速度(生成与消费速率)和粘度(关联复杂度)共同构成了它的“质量”,进而产生类似引力的效应。

这种效应主要体现在三个维度:

- 迁移成本引力:移动1TB数据跨越大陆的成本可能微不足道,但移动1PB数据可能就需要慎重考虑,而移动1EB数据在经济和时间上几乎变得不可行。AWS前首席布道师杰夫·巴曾直言:“数据是有质量的。当数据达到PB级,它就变得‘粘稠’,难以移动。”

- 计算亲和引力:处理大规模数据的计算任务会自然而然地被拉向数据所在地。你会选择将100个节点的计算集群送到数据所在的数据中心,而不是将PB级数据送到计算集群。这种引力重塑了云计算的成本模型。

- 服务与生态引力:一旦核心数据沉积在某个平台(如某个云厂商的特定存储服务),与之配套的分析工具、机器学习服务、开发团队技能栈都会像卫星一样被吸附过来,形成日益增强的生态锁定。

一个反直觉的真相是:在TB时代,我们架构的核心命题是“如何高效地处理数据”;在PB/EB时代,核心命题已悄然变为“如何让计算去就数据,而不是让数据去就计算”。 我们过去十年优化的数据传输网络、引以为傲的“存算分离”架构,在数据重力面前,可能正面临着基础性的重构压力。

02 传统架构的“重力失控”:为何存算分离遇到天花板?

存算分离是现代数据架构的基石理念之一:存储层独立扩展,计算层按需弹性。这套范式在数据规模可控时优雅而高效。然而,当数据重力达到临界点,它的脆弱性开始暴露。

最直接的冲击是网络带宽成为无法绕开的瓶颈。即使拥有100Gbps的专线,传输1PB数据也需要超过24小时。而在自动驾驶、卫星影像分析、基因组学等领域,日增数据量就在数十PB级别。这导致计算资源在大部分时间处于闲置等待状态,数据移动时间超过了数据处理时间本身,所谓的“弹性计算”在数据传输的刚性延迟面前失去了意义。

更深层的是成本模型的非线性跃迁。在云端,数据移动(尤其是跨区域、跨云出口)的成本并非线性增长。当数据规模较小时,这部分成本可忽略不计;但当规模突破阈值,它会迅速成为账单上的主导项。一家全球化媒体公司发现,当他们用于全球内容推荐的数据集增长到5PB后,跨区域数据同步的月度成本竟然超过了存储这些数据本身成本的3倍。他们优化的不再是算法效率,而是数据的地理位置。

更隐蔽的挑战在于状态与本地性的丧失。存算分离架构中,计算是无状态的、临时的。但对于大规模迭代式机器学习训练或复杂图计算,每次计算都需要重新加载海量数据,大量重复的I/O操作和序列化/反序列化开销吞噬了性能。数据与计算之间的“距离”——即使只是网络延迟和协议开销——被数据重力无限放大。

这迫使我们承认一个日益明显的事实:对于一定规模以上的数据,将它们留在原地,让计算“上门服务”,可能比建立一个集中式的、存算分离的“数据神殿”更为经济高效。 这本质上是对我们过去十年架构信仰的一次重大修正。

03 新架构原则:在数据引力场中优雅航行

接受数据重力的存在,并不意味着放弃架构的优雅。相反,它要求我们发展出一套新的设计原则,在这片新的引力场中实现平衡与效率。

第一原则:计算向数据迁移,而非相反

这是最根本的范式转变。架构设计的起点不再是“我的计算集群在哪里”,而是“我的核心数据资产沉积在哪里”。对于批处理作业,这意味着将计算任务调度到数据所在的存储节点或可用区执行(如HDFS的“数据本地化”或云厂商的“区域亲和”策略)。对于流处理和新一代的“湖仓一体”架构,这意味着在数据摄入的入口处就部署轻量级的预处理、筛选和聚合逻辑,只让有价值的数据摘要或元数据参与长距离流动,从源头削减“质量”。

第二原则:建立数据的“分层引力场”

并非所有数据都有相同的重力。我们可以根据数据的温度(访问频率)、价值密度和关联性,设计分层的存储与计算布局。

- 热数据(高重力):高频访问的PB级核心数据集,应配备强大的本地化计算能力。考虑采用存算一体的专用硬件(如高性能一体机或带有计算能力的智能存储),甚至需要重新评估大规模部署GPU/TPU等异构算力到数据所在地的经济性。

- 温数据(中重力):可通过高效的缓存层、索引层和聚合视图,在距离计算资源合理的位置建立数据的“引力子集”,让多数查询无需触及全量数据。

- 冷数据/元数据(低重力):将全量数据的精简元数据、统计摘要和索引集中管理,形成一个全局的、轻量的“引力导航图”。大部分探索性查询和调度决策基于这张图完成,只有最终的必要计算才被精准导向具体的数据体。

第三原则:将“数据移动”提升为头等架构事件

在传统架构中,数据同步、备份和迁移是运维流程的一部分。在数据重力时代,任何涉及大规模数据移动的操作都必须被视为与核心业务逻辑变更同等级别的架构事件。它需要独立的成本效益分析、详细的影响评估和专门的调度优化。架构师需要像设计数据库分片一样,精心设计数据的分布、复制和迁移策略,目标是最小化不必要的数据质量移动。

04 技术栈的重构:适应重力的新工具与新思维

随着数据重力的显现,技术栈也在发生静默但深刻的重构。

存储层正在从被动的“数据仓库”演变为主动的“数据计算节点”。诸如Snowflake的“虚拟仓库”、Databricks的Photon引擎,以及云厂商推出的与对象存储深度绑定的无服务器计算服务(如AWS Lambda与S3的集成,Google BigLake),其本质都是在模糊存储与计算的边界,让计算能力更自然地渗透到数据层。

计算范式上,我们正在从“搬运数据到计算程序”转向“分发计算程序到数据所在”。这不仅是Kubernetes调度器的一个标签(nodeAffinity),更是Spark、Flink等分布式计算框架的核心理念演进。而边缘计算的兴起,可以看作数据重力在物联网场景下的极致体现:数据在源头产生,就在源头处理,只有提炼后的结果或模型更新发生移动。

成本优化的焦点,也从单纯追求计算资源的利用率(如CPU使用率),转向一个更复杂的多变量优化问题:数据存储成本 + 数据移动成本 + 计算资源成本 + 时间延迟成本。优秀的架构师需要在这四者之间找到针对特定业务的最优平衡点,而这个平衡点会随着数据规模的增长而动态漂移。

05 战略启示:从技术约束到商业护城河

数据重力的影响最终会超越技术部门,触及商业战略的核心。

首先,它迫使企业重新评估数据中心与云的区域战略。数据重力使得“将所有数据集中到一朵超级云”的想法可能不再是最优解。混合云、分布式云、乃至“数据主权云”的布局,可能更多是由核心数据资产的物理位置和监管要求(这为数据增加了另一种“政治质量”)所决定的,而非单纯的技术偏好。

其次,它可能催生新的商业护城河。当你的业务积累了独一无二的、规模巨大的核心数据集(例如,连续十年的城市级高清地图数据、数十亿用户的个性化交互历史),这些数据产生的巨大“重力”本身就成了难以逾越的壁垒。竞争对手不仅难以获得同等质量的数据,更难以承担重建一套能高效处理这些数据的、与数据位置深度耦合的基础设施的代价。数据重力将数据资产的价值,从内容本身,部分地固化到了其所处的处理环境与生态中。

最后,它定义了组织内的新协作模式。数据团队不能再只关心“数据有什么”,基础设施团队也不能只关心“资源怎么给”。他们必须共同回答:“我们的核心数据资产在哪里?它们的‘重量’如何?我们的计算策略应该如何与之共舞?” 这需要一种贯穿数据生命周期与基础设施规划的、更深层的架构协同。

回到那家自动驾驶公司。他们最终放弃了将全球数据汇聚到单一超级集群的“宏伟计划”。取而代之的,是在欧洲、北美和亚洲的数据采集中心附近,分别建立了区域性的训练集群。每个集群处理本地产生的大部分数据,只将训练得到的模型参数和精华数据集进行跨区域同步。

这个转变不是技术上的倒退,而是对物理现实和数据经济学的成熟接纳。他们不再与数据重力对抗,而是学会了利用它。计算资源离数据更近,等待时间消失,研发节奏加快。更重要的是,他们意识到,这种基于数据重力规划的分布式架构,本身就成了其全球化运营的一项战略性韧性资产——任何一个区域的故障,都不会导致全局研发的停滞。

数据重力的觉醒,标志着一个粗放扩张时代的结束和一个精细运营时代的开始。它提醒我们,在数字世界的底层,物理定律依然有效:质量产生引力,引力塑造时空,而所有的架构,都是在特定的时空中寻找最优路径的艺术。

当你的数据规模突破下一个数量级时,你所面对的将不仅仅是技术挑战,更是一场关于如何重新理解成本、时间和空间价值的思维革命。真正的问题是:当数据变得如此之“重”,你的架构,准备好迎接这场重力考验了吗?