凌晨三点,你刚部署的新推荐算法开始服务线上流量。监控显示一切正常——直到客服电话被打爆:“为什么我给女朋友买的戒指,推荐页全是葬礼用品?” 你连夜排查,最终发现问题不在算法,而在于那条跨越七个系统、经过三次转换的“用户标签”数据流中,一个字段的语义在某个环节被静默覆盖了。

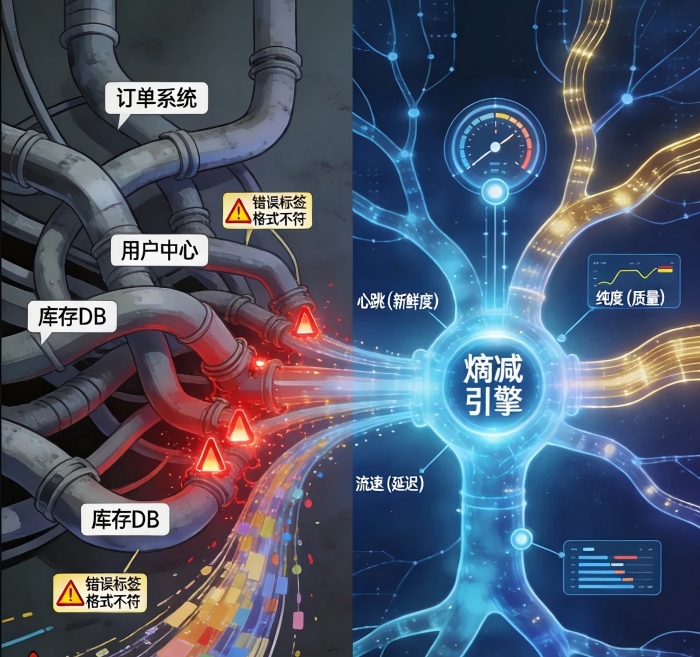

我们都经历过这种时刻:当系统越来越智能,数据却越来越混乱;当决策要求越来越实时,数据同步却越来越延迟。我们构建了无数数据管道,却发现自己身处一个由数据碎片组成的迷宫中。

今天我想和你聊聊数据工程中那个最根本的挑战:熵增定律在数据领域的无情体现,以及我们如何通过构建一条高保真、低延迟的全局数据血脉来实现“熵减”。

数据的“热寂”:为什么我们的系统越智能,数据越混乱?

在物理学中,熵增定律指出:孤立系统的无序度总会增加。数据系统同样遵循这一定律——每增加一个微服务、每引入一个新数据源、每进行一次数据转换,数据的混乱度就必然增加。

这个现象的规模超乎想象。根据2024年《企业数据复杂性报告》,一家典型的中型互联网公司(约500项微服务)每天产生的数据转换错误或语义不一致事件超过1500起,其中能被现有监控发现的不足20%。更令人不安的是,数据工程师70%的时间花在了追溯“数据为何变脏”上,而非创造新价值。

问题不在于我们不够努力,而在于我们的作战方式存在根本缺陷。我们建造了一条条数据管道——单向的、孤立的、专注于特定任务的水管。但当这些管道成百上千时,没有哪个人能理解整个水系图。一处泄漏、一次污染,会悄无声息地波及下游所有系统。

我们需要的是从“管道思维”到“血脉思维”的范式转变。血脉是循环的、连通的、自愈的。它要求血液(数据)在全身(所有系统)中保持成分一致(高保真)、流动顺畅(低延迟),并且任何一个部位的异常都能被迅速感知和定位。

第一层熵减:语义一致性——从“巴别塔”到“通用语”

数据混乱的首要表现是语义熵增:同一个业务概念在不同系统中有着不同名字、不同格式、不同更新逻辑。

想象这个场景:在用户服务中,“注册时间”指用户点击注册按钮的时间;在订单系统中,“注册时间”被重新定义为用户首次下单时间;在风控系统里,这个字段可能又被处理为“账户通过实名认证的时间”。当这三个“注册时间”流入数据仓库,被分析师不加区分地使用时,灾难就埋下了伏笔。

实现语义熵减需要一场“数据宪法运动”——建立企业级的统一语义层。这不是又一个数据字典,而是一个活生生的、有约束力的协议层。它的核心是:

- 数据产品化思维:将核心业务实体(用户、商品、订单)封装为有明确服务承诺的“产品”。比如“用户档案”这个数据产品,必须承诺提供最新的联系方式、完整的交易历史、一致的标签体系。

- 知识图谱作为骨干:用图谱而非表格来建模业务现实。在图谱中,“用户”是一个节点,它与“订单”、“地址”、“支付方式”等节点的关系是显式声明的,而非隐藏在代码逻辑中。当某个系统试图错误地连接这些关系时,图谱可以立即告警。

- 合约化接口:每个系统消费数据必须通过显式合约,就像调用API需要看文档一样。任何对数据语义的误解都会在合约检查阶段暴露。

领英的DataHub、优步的Amundsen等现代数据发现平台正朝这个方向演进。它们不再只是数据目录,而是语义一致性的执行者。

第二层熵减:时效性革命——当“实时”成为基础设施的默认配置

传统数据架构有一个难以启齿的真相:我们的大部分数据系统本质上是“时光机”——它们展示的是过去的状态,却要支持现在的决策。

电商行业有个经典问题:用户已退货的商品,为何还会被推荐给同一位用户?因为推荐系统使用的“用户偏好”数据更新频率是T+1,而退货发生在“现在”。这个时间差造成的糟糕体验,直接转化为流失率。

低延迟数据血脉要求我们重新思考数据流动的基本单元。不再是“表”,而是“事件”;不再是“批量”,而是“流式”。

CDC(变更数据捕获)技术 的成熟是这场革命的关键。通过读取数据库日志而非查询表,CDC可以将一次“订单状态从‘已支付’变更为‘已发货’”的事件,在毫秒级内通知所有相关系统。这不仅仅是技术优化,更是架构哲学的改变:

- 状态同步变为事件传播:下游系统不再需要定期“抓取”最新状态,而是监听自己关心的事件

- 数据一致性从“最终”变为“实时”:基于事件的传播天然保证了所有系统几乎同时感知到变化

- 复杂度转移:从应用层复杂的“谁在什么时候更新了什么”逻辑,下沉为基础设施层的可靠消息投递

更重要的是,流批一体架构 让实时与离线不再是非此即彼的选择。Apache Flink、Spark Structured Streaming等框架允许同一套逻辑既处理实时流,也处理历史批数据。这意味着你的“实时用户画像”和“离线用户分析”背后是同一套计算、同一种语义。

反常规的视角是:有时,“足够快”比“绝对一致”更有价值。在分布式系统中追求所有节点的强一致性,往往以牺牲可用性和延迟为代价。而许多业务场景(如个性化推荐、动态定价)可以接受短暂的数据不一致(最终一致性),但不能接受高延迟。数据血脉的设计需要明确每个数据流的一致性-延迟权衡点。

第三层熵减:可观测性渗透——让数据流动“透明化”

即使解决了语义和时效问题,我们仍面临信任危机:当数据分析结果与直觉不符时,如何快速判断是业务真实现象,还是数据流水线中的某个环节出错了?

当前的数据可观测性大多停留在“管道是否有故障”的层面,远未达到“数据是否正确反映了业务现实”的高度。我们需要的是全链路的数据可观测性,它包括:

- 血缘可追溯:不仅仅是表级血缘,而是字段级、转换级的血缘。当某个指标异常时,能立即定位到是哪个源字段、经过哪些转换后出了问题。

- 质量可度量:在每个关键节点定义并监控数据质量指标——新鲜度、完整性、准确性、一致性。这些指标不应是事后报告,而是实时熔断器:当质量跌破阈值,应能自动阻断下游消费,防止“垃圾进,垃圾出”的级联效应。

- 影响可评估:当某数据源或处理逻辑变更时,能精确评估哪些下游业务、报表、模型会受到影响。这改变了数据变更的协作模式——从“先改了再说”到“先评估影响再执行”。

让人意外的是,最先进的实践正在向“数据单元测试”方向发展。就像代码有单元测试确保逻辑正确一样,数据流水线的每个转换阶段也应该有测试断言:“客户年龄必须在18-120之间”、“订单金额不能为负”、“这两个系统的用户数差异不应超过5%”。这些测试随着数据一起流动,在数据出错时立即告警。

构建血脉:从理念到实践的三步走

理论令人兴奋,实践充满挑战。构建全局数据血脉不是一夜之间的革命,而是精心规划的演进:

第一阶段:绘制“血管图”

从最重要的业务场景开始,逆向绘制数据流图。不要试图一次性覆盖所有系统,而是选择那些数据错误会导致直接业务损失的场景(如交易、库存、核心用户画像)。使用数据发现工具自动扫描,但更重要的是与业务负责人深度访谈,理解他们决策时真正依赖的数据是什么。

第二阶段:建立“心脏”与“主动脉”

确定企业的核心数据产品(通常不超过10个),如“黄金客户记录”、“权威产品目录”、“事实交易流水”。为这些产品建立最高标准的语义定义、质量要求和时效承诺。它们是数据血脉的“心脏”,必须首先保证它们的强壮。

同时,建立几条“主动脉”——跨部门、跨系统的高优先级数据流。为这些流动实施端到端的可观测性,包括字段级血缘和实时质量监控。

第三阶段:推动“毛细血管”渗透

当核心血脉运行稳定后,逐步将更多系统和数据流纳入这个体系。这时,自动化是关键:自动发现新数据源、自动推荐语义映射、自动生成质量检查规则。让加入血脉体系的边际成本趋近于零。

血脉的价值:超越技术,关乎信任

让我分享一个真实案例。某金融科技公司实施了数据血脉体系后,发现了一个隐藏多年的问题:他们的风险模型基于的“用户月收入”字段,在三个核心系统中的计算逻辑竟然完全不同。修复这个不一致后,模型对高风险用户的识别准确率提升了34%,而他们之前一直以为模型本身已经优化到极限。

这就是数据血脉的终极价值:它建立的不仅是一条高效的数据流动通道,更是一个可信的数据环境。在这个环境中:

- 分析师可以相信他们查询的数据反映了真实的业务状态

- 算法工程师可以相信特征工程的基础是坚实一致的

- 业务决策者可以相信他们看到的数据不是互相矛盾的多个版本

当我们谈论数字化转型、智能决策、AI赋能时,往往着眼于炫酷的上层应用。但所有这些都运行在数据这块地基上。一条高保真、低延迟的全局数据血脉,可能不会让你的下一个PPT更华丽,但它决定了你的数字大厦能建多高、立多久。

数据血脉的建设,本质上是对抗熵增的永恒努力。它不会有一劳永逸的终点,但每减少一处语义混乱、每缩短一秒同步延迟、每提前一刻发现问题,我们都在让数据更值得信赖,让基于数据的决策更加明智。

深夜的数据事故还会发生,但原因将不再是“数据又不对了”,而是我们遇到了全新的、值得深入研究的业务现象——这或许才是数据工程师最愿意面对的挑战。