人工智能(AI)和机器学习(ML)正在以前所未有的速度渗透到各行各业,从自动驾驶汽车到个性化推荐,再到复杂的科学研究。这股浪潮的背后,是对强大计算能力的巨大需求。然而,并非所有服务器都生而平等,尤其是面对 AI 工作负载时。标准的 Web 服务器或数据库服务器往往难以胜任 AI 任务,因为 AI,特别是深度学习,对其硬件有着非常特殊且严苛的要求。

更进一步说,AI 的两大核心阶段——**训练 (Training)** 和 **推理 (Inference)**——对服务器硬件的需求也存在显著差异。理解这些差异,对于合理规划、选购或租赁 AI 服务器,避免资源浪费或性能瓶颈至关重要。本文将深入解析 AI 训练和推理对服务器各关键组件(GPU、CPU、内存、存储、网络等)的特殊要求。

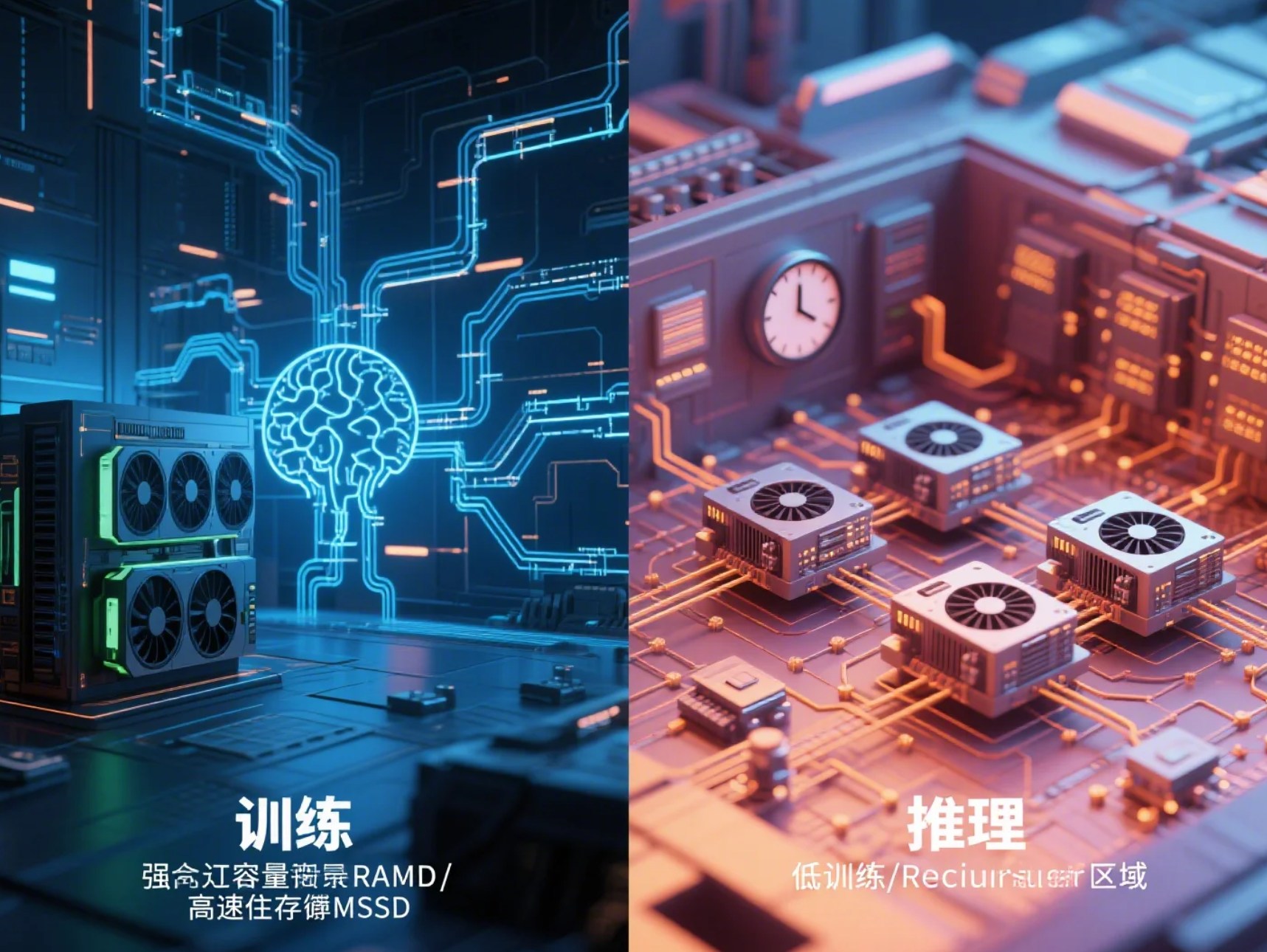

AI训练 (Training) vs. AI推理 (Inference):核心差异

在深入硬件细节之前,我们先快速区分一下这两个概念:

- AI 训练 (Training): 这是“教”模型学习的过程。通常涉及将庞大的数据集(如数百万张图片、大量文本)“喂”给神经网络模型,通过反复迭代调整模型内部的参数(权重),使其能够识别模式、做出预测或生成内容。这是一个计算极其密集、耗时(可能需要数小时、数天甚至数周)且对数据吞吐量要求很高的过程。

- AI 推理 (Inference): 这是使用“已经训练好”的模型进行实际应用的过程。例如,用训练好的图像识别模型去判断一张新图片里是猫还是狗,或者用训练好的语言模型进行实时翻译。推理通常对**延迟 (Latency)** 更敏感(需要快速得到结果),并且可能需要同时处理大量并发请求(高**吞吐量 Throughput**)。它可以发生在云端服务器,也可以发生在边缘设备(如手机、摄像头)上。

正是因为训练和推理在计算特性、数据需求和性能目标上的不同,它们对服务器硬件的侧重点也大相径庭。

AI训练服务器的核心要求

训练大型深度学习模型是目前对服务器资源要求最高的任务之一。以下是其关键硬件需求:

1. 强大的GPU计算能力 (核心中的核心)

原因: 深度学习训练的核心是大量的矩阵和张量运算。GPU(图形处理单元)拥有数千个计算核心,其大规模并行处理架构使其在此类运算上的速度远超传统 CPU(通常快数十倍甚至上百倍)。可以说,没有强大的 GPU,高效的深度学习训练几乎无从谈起。

关键 GPU 指标:

- CUDA 核心 / Tensor Cores (张量核心): 对于 NVIDIA GPU 而言,CUDA 核心是基础并行计算单元。而 Tensor Cores 是专门为深度学习中的混合精度(如 FP16/BF16 结合 FP32)计算设计的加速单元,能极大地提升训练速度和效率。支持 Tensor Cores 的 GPU 在 AI 训练中优势明显。

- 显存 (VRAM) 容量: 这是 GPU 自带的高速内存。训练时需要将模型参数、输入数据批次 (batch)、梯度以及优化器状态等都加载到显存中。模型越大、批次越大,所需显存就越多。显存不足会导致训练失败或必须减小批次大小(可能影响收敛效果)。常见的数据中心级 GPU 显存可达 40GB、80GB 甚至更高。

- 显存带宽: 指 GPU 核心与其显存之间数据传输的速度(单位通常是 GB/s)。高带宽对于确保计算核心不被数据饥饿至关重要,尤其是在处理大型模型和数据时。HBM2/HBM2e/HBM3 等高带宽内存技术是高端 AI GPU 的标配。

- 多 GPU 互联技术 (NVLink/NVSwitch): 单块 GPU 的性能和显存有限,训练超大型模型通常需要多块 GPU 甚至多台服务器协同工作。NVIDIA 的 NVLink 技术提供了远高于传统 PCIe 的 GPU 间直连带宽,NVSwitch 则能实现更多 GPU 之间的高速全互联,这对于分布式训练的效率至关重要。

常见选择: 数据中心通常选用 NVIDIA 的 A 系列 (如 A100, A30) 或 H 系列 (如 H100) GPU。工作站或预算有限的场景可能会考虑高端的 RTX 系列(如 RTX 4090, RTX 6000 Ada),但需注意其驱动、散热和多卡互联能力可能与数据中心卡有差异。(我们将在后续的文章中详细讨论 GPU 的选型。)

2. 高性能CPU

原因: 虽然 GPU 执行大部分核心计算,但 CPU 仍然扮演着重要角色:它负责操作系统运行、数据加载和预处理(解压缩、增强等)、将数据传输给 GPU、协调 GPU 任务,有时也运行模型中不适合 GPU 的部分。如果 CPU 性能太弱,可能会成为数据准备或任务调度的瓶颈,导致 GPU 空闲等待。

关键 CPU 指标:

- 核心数量: 较多的核心有助于并行处理数据加载和预处理任务。

- 时钟频率: 更高的频率意味着更快的单核处理速度。

- PCIe 通道数量和版本: 这是 CPU 与 GPU 及其他外设(如 NVMe SSD、网卡)通信的桥梁。CPU 需要提供足够数量和足够高版本的 PCIe 通道(如 PCIe 4.0 或 5.0),以保证每块 GPU 都能获得足够的带宽(通常是 x16)。PCIe 通道不足会严重限制 GPU 性能。

3. 大容量高速内存 (RAM)

原因: 服务器内存(RAM)用于存放操作系统、正在处理的数据集(或其中的批次)、模型的部分数据、以及 CPU 与 GPU 之间传输的中间数据。如果内存不足,系统会频繁使用速度慢得多的硬盘作为虚拟内存(Swap),导致训练速度急剧下降。

关键 RAM 指标:

- 容量: 取决于数据集大小、数据加载方式、使用的 CPU 核心数以及 GPU 数量。通常建议 RAM 容量是总 GPU 显存容量的 2 到 4 倍或更多。128GB、256GB、512GB 甚至 TB 级别的内存在 AI 训练服务器中很常见。

- 速度/频率: 更高频率的内存(如 DDR4-3200, DDR5-4800+)可以加快 CPU 访问数据的速度。

- ECC (Error Correcting Code): ECC 内存可以检测并纠正单位内存错误,对于需要长时间稳定运行(数天或数周)的训练任务来说,能显著提高系统的可靠性,推荐使用。

4. 高速存储 (NVMe SSD)

原因: 训练需要快速地从硬盘读取大量数据到内存中。如果存储速度跟不上数据加载的需求,CPU 和 GPU 就得等待,造成 I/O 瓶颈。

关键存储指标:

- 读写速度和 IOPS: NVMe (Non-Volatile Memory Express) SSD 通过 PCIe 总线直接连接 CPU,提供远超 SATA SSD 的读写速度和 IOPS(每秒读写操作次数),是 AI 训练服务器存储的首选。

- 容量: 需要足够容纳操作系统、应用程序、以及可能非常庞大的训练数据集(可能达到 TB 甚至 PB 级别)。可能需要多块 NVMe SSD 组成 RAID 阵列来提供更大容量和更高性能。

5. 高带宽网络

原因: 当训练任务需要在多台服务器之间进行分布式训练时,服务器之间需要高速、低延迟的网络来同步模型参数(梯度)。同时,如果数据集存储在网络文件系统(如 NFS, Lustre)或对象存储上,也需要高带宽网络来快速获取数据。

关键网络指标:

- 带宽: 至少需要 10GbE,更常见的是 25GbE、40GbE、100GbE 甚至 200/400GbE。

- 延迟: 低延迟对于分布式训练中的同步操作至关重要。

- 技术: RDMA (Remote Direct Memory Access) 技术(如 InfiniBand 或 RoCE – RDMA over Converged Ethernet)可以绕过 CPU 直接在服务器内存和网卡之间传输数据,显著降低延迟和 CPU 负担,在大型 AI 训练集群中广泛应用。

6. 可靠的电源和散热

原因: 高端 AI GPU 和 CPU 是“电老虎”和“发热大户”。一块旗舰级 GPU 的功耗可达 300-700W,一台配备多块 GPU 的服务器总功耗可能达到数千瓦。这要求服务器必须配备功率充足、质量可靠的电源供应单元(PSU),最好是冗余电源。同时,强大的散热系统(高效风冷或液冷方案)对于防止硬件过热降频甚至损坏至关重要。

AI推理服务器的要求 (有所不同)

与训练相比,推理的目标是快速、高效地使用模型进行预测,其硬件要求侧重点有所不同:

1. 合适的加速器 (GPU或其他)

选择考量: 虽然训练用的高端 GPU 也能用于推理,但往往功耗高、成本高。推理任务更关注**每瓦性能 (Performance per Watt)** 和 **延迟**。因此,可能会选用:

- 中低端或专门的推理 GPU: 如 NVIDIA 的 L4, T4 系列 GPU,它们针对推理优化,功耗较低。

- 专用 AI 加速器: 如 Google TPU (Tensor Processing Unit), Intel Gaudi, AWS Inferentia, 以及各种 FPGA 或 ASIC 推理芯片,它们在特定推理任务和精度(如 INT8)下可能提供更高的能效比。

关键指标: 推理吞吐量 (Inferences Per Second, IPS)、单次推理延迟、支持的精度(FP32, FP16, INT8 等,低精度通常更快更省电)、功耗、成本。

2. 均衡的 CPU

作用: 主要负责接收推理请求、调度任务给加速器、进行数据预处理和后处理。不需要像训练服务器那样极其强大的 CPU,但需要足够的处理能力来应对并发请求,避免成为瓶颈。

3. 足够的内存 (RAM)

需求: 需要加载操作系统、推理引擎软件、以及一个或多个预训练模型。通常,推理模型比训练过程中的状态占用内存要小,所以内存容量需求一般低于训练服务器,但仍需保证足够。

4. 快速的网络接口

重点: 对于提供实时服务的推理应用(如在线翻译、语音识别),**低网络延迟**至关重要。标准的千兆以太网 (GbE) 或万兆以太网 (10GbE) 通常足够,具体取决于所需的并发吞吐量。

5. 存储要求相对较低

需求: 主要用于存储操作系统和预训练好的模型文件。使用 SSD(SATA 或 NVMe)有助于快速加载模型,但通常不需要像训练服务器那样TB级别的海量存储空间。

6. 成本效益和功耗

考量: 推理服务往往需要 7×24 小时运行,并且可能部署在大量服务器上。因此,单个服务器的购置成本、运维成本以及功耗(直接影响电费)变得非常重要。选择能效比高的硬件方案对于控制总体拥有成本 (TCO) 很关键。

总结

为 AI 工作负载选择服务器并非易事。我们需要清晰地认识到:

- AI 训练 是一个计算和数据密集型的过程,极度依赖**强大的 GPU**(高算力、大显存、高带宽)、高性能的 CPU、大容量高速内存、快速的存储以及(对于分布式训练)高带宽低延迟的网络。

- AI 推理 则更侧重于**低延迟、高吞吐量和高能效比**,可能选用功耗更低、针对性优化的 GPU 或专用 AI 加速器,对 CPU、内存和存储的要求相对训练要低一些,但对网络延迟可能更敏感。

理解这些核心需求差异,是您为特定 AI 应用场景选择或构建合适服务器硬件平台的第一步,有助于您做出明智的投资决策,避免“杀鸡用牛刀”或“小马拉大车”的窘境。

在接下来的文章中,我们将更深入地探讨如何具体选择 GPU,敬请期待!