你有没有遇到过这样的怪事:服务部署得好好的,配置没动,某天用户突然连不上;重启网络或者设备后,又恢复正常——然后再过一段时间,又“神秘”断掉?抓包查日志都没有结果?

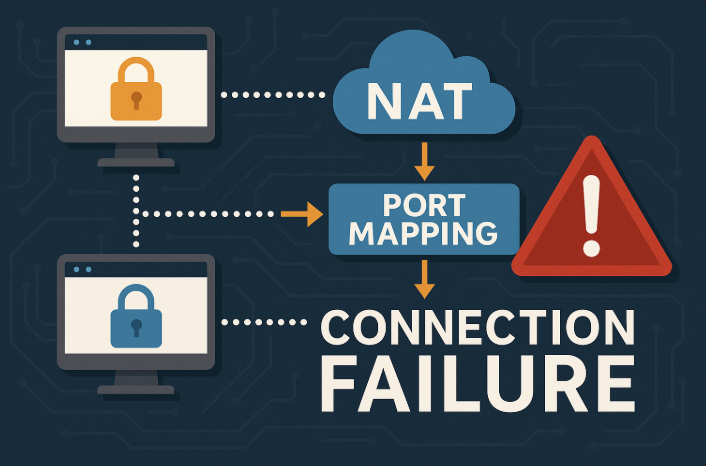

很可能你遇上了 NAT(网络地址转换)背后的“隐形杀手”——端口映射冲突。

NAT 是什么,怎么就成了问题的根源?

我们先不讲术语,讲个现实场景:

设想你家只有一个公网 IP,但家里有手机、电视、电脑都需要上网。这时候就需要用 NAT,把一个公网地址“变戏法”地映射给多个内网设备使用。这没问题,直到你开始玩“高级操作”:多个设备对外提供服务、做端口转发。

这时候,一个公网 IP 同时映射多个内网端口时,如果管理不好,就像多个房客争抢一把钥匙,必定会出问题。

端口映射冲突到底是什么鬼?

说白了,就是多个不同服务、不同主机,尝试把相同的公网端口映射到内网的不同地址上,结果导致映射表错乱或被覆盖。常见的场景包括:

- Docker 容器动态分配端口,冲突后服务连接异常;

- 同一公网 IP 上部署多个 VPN 或 Web 服务,默认抢占了 443/80 端口;

- 公司路由器 NAT 表爆满,旧连接占着端口不释放,新连接映射失败。

冲突时,用户访问的其实并不是你以为的服务,而是被错误映射的另一个地址或直接连接失败。

NAT 转换类型全盘点:你踩的坑在哪种?

我们先分清楚常见的几类 NAT:

| NAT 类型 | 特点 | 风险点 |

|---|---|---|

| 静态 NAT | 一一映射,固定端口 | 配置错误易被忽视 |

| 动态 NAT | 多对一,端口动态分配 | 表满时连接失败 |

| PAT(端口地址转换) | 最常见的一种,用端口号区分不同连接 | 容易发生冲突 |

你在企业网络、数据中心或公有云 NAT 网关里遇到的大多数问题,都是出在PAT 冲突或者表满/回收慢上。

多人环境+多云部署 = 冲突“灾难现场”

假设你在腾讯云开了一台 NAT 网关,后台还连着一堆容器、VPN、数据库、GitLab、CI/CD 工具,甚至还有一堆临时的调试环境。每个人都把“80”、“443”、“22”写在自己的脚本里,从来不管有没有冲突。

结果会怎样?

- A 同事部署了个 Web 服务,用 443;

- B 同事也部署了一个服务,也试图用 443;

- NAT 网关可能默默把后者的规则顶替了前者,谁都不知道;

- 外部用户连进来,结果访问的是错的服务,甚至连不上。

更致命的是,云厂商有时候不会明确提示你端口映射失败,只是悄悄没生效。

抓不到日志?因为 NAT 根本不告诉你

你以为你抓包就能查出原因?大多数 NAT 设备根本不会记录转发表的详细状态。NAT 转换是内核态的行为,不同厂商、不同设备甚至不给你看转发表或者日志。

所以很多时候你只能看到:

- ping 通;

- traceroute OK;

- 连接失败,服务端没日志,客户端也没错报……

这时候你是不是觉得“这一定是网络的锅”?其实就是 NAT 在背后搞鬼。

多用户环境下怎么避免端口映射地狱?

想彻底规避这些问题,有几套实战方案可以参考:

✅ 1. 所有映射用自动化工具统一管理

用 Ansible、Terraform 或脚本统一定义 NAT 映射规则,避免人工“手工改配置”。并且每次更新都审查端口占用情况。

✅ 2. 保留专属端口范围

给每个服务或开发人员分配固定的端口区间,如 30000–31000。谁用哪个,一清二楚,冲突概率大大降低。

✅ 3. 结合动态端口分配系统

借助 Kubernetes 或服务发现工具(如 Consul)做服务注册,结合 Ingress 控制器做智能转发。

比如:

bashiptables -t nat -A PREROUTING -p tcp --dport 30080 -j DNAT --to-destination 10.0.0.12:80

配合 DNS 自动同步服务地址,避免固定 IP 或端口冲突。

✅ 4. 实时监控 NAT 映射表

如果你用的是支持 API 的云 NAT 网关,如阿里云、腾讯云,可以定期调用接口查看转发表内容,判断是否有端口重复、异常多的动态条目、老旧连接未清除等问题。

✅ 5. 设置连接超时时间

某些 NAT 设备会长时间保存旧连接,导致新连接无法建立。配置合理的会话超时时间(如 TCP 保活、NAT 回收规则)可减少表满问题。

多点可达检测也能揭穿 NAT 问题

你可以结合“多点 Ping”、“端口连通性测试”策略,从多个探针节点去探测目标公网 IP 的不同端口可达性。比如:

bashnmap -p 22,80,443 your.domain.com

或者自己写脚本从多个云主机发 curl 或 telnet,收集延迟和可达率,再比对 NAT 映射是否正常。

如果某个端口在一半探针上连接失败,说明 NAT 映射可能区域性失效或者绑定问题。

云厂商的坑也要提防

你以为用云 NAT 网关就高枕无忧?那你真低估了“托管服务”的魔性:

- 云 NAT 通常有最大连接数限制,一超标就回收连接,某些服务因此掉线;

- 某些云厂商的端口限制不公开,可能 1024 以下需要特别授权或白名单;

- 异地双活部署时,两边抢占同一公网 IP + 端口,NAT 映射就会互相打架。

解决办法:

- 用不同的 EIP 分区部署服务;

- 明确端口使用权;

- 最好把负载均衡配置在 NAT 之前。

那到底有没有“万能”的规避策略?

说实话,没有。NAT 本身就不是为复杂场景设计的。

但你可以遵循以下通用原则:

- 能用公网 IP 就别 NAT(直接部署在云主机上);

- 避免使用“热端口”(如 22, 80, 443 等);

- 每个服务的 NAT 映射要文档化;

- 用统一平台做端口管理(例如 Portainer、KubeSphere 这类面板);

- 搭配多探针 + 可达率监控,能第一时间识别冲突或失效。

写在最后

NAT 的问题不是“技术太差”,而是它被滥用在了原本不适合的场景中。

从最早的“公网 IP 不够用”,到如今“云环境里过度集中”,NAT 被强行套在多用户、多服务、多实例的场景下,导致无数连接失败、服务抽风、告警误报。

而端口映射冲突就是那根你看不到但总会被绊倒的“电线”。

你越早在 NAT 管理上下功夫,越能减少那种“明明服务没错,却总有人访问不到”的烦恼。