当一家头部AI公司的训练集群满负荷运转时,技术总监看着监控仪表盘陷入沉思——他们价值数千万美元的通用CPU服务器集群,正以低于15%的利用率“空转”,而旁边的GPU资源却持续满载、排队等待。他们拥有海量算力,却像一座只有大型货轮码头却没有集装箱吊机的港口。

这不是资源配置失误,而是一个时代性架构错配的缩影。我们正站在一个历史转折点上:过去四十年以CPU为中心、追求指令级并行的“通用计算”范式,正在被以数据为中心、追求任务级并行的“异构智算”范式所取代。今天,我们不谈论具体的AI芯片参数,而是像老友围炉夜话,共同审视一场正在发生的基础设施底层重构——当计算的目标从“处理信息”转向“创造智能”,服务器本身需要如何被重新定义?

01 “AI计算墙”:通用架构为何撞上性能天花板?

要理解架构跃迁的必要性,首先得看清那道日益增厚的“AI计算墙”。这道墙不是工艺制程的限制,而是冯·诺依曼架构本身与AI工作负载特性之间的结构性矛盾。

AI计算,尤其是深度学习,呈现出与通用计算截然不同的特征:

- 计算模式极度专一:以大规模矩阵乘法(GEMM)和张量操作为核心,而非多样化的指令混合

- 数据移动成为主要瓶颈:模型参数动辄数百GB,激活值在内存与计算单元间频繁搬运,数据搬运的能耗可能数十倍于计算本身

- 容错性革命:AI计算对数值精度要求相对宽松(可采用FP16、BF16甚至INT8),但对计算吞吐量和内存带宽极为敏感

- 工作负载的“间歇性爆发”:训练任务需要持续数天甚至数周的高强度计算,而推理则可能面临极不均衡的实时请求

在传统x86架构中,CPU像一位“全科医生”,设计目标是高效处理各种不同的任务。但当95%的工作都变成“矩阵乘法”这一种“病症”时,让全科医生日复一日只做同一台手术,其效率低下就暴露无遗。更糟糕的是,CPU的计算与内存分离的架构,使得数据需要在内存控制器、多级缓存和计算核心之间长途跋涉,而AI计算恰恰是“数据密集”远胜于“计算密集”。

一个令人警醒的数据来自斯坦福大学AI指数报告:自2012年以来,AI模型的计算需求每3.4个月翻一番,远超摩尔定律(每18-24个月翻一番)的步伐。这意味着,单纯依靠制程进步和传统架构优化,已经无法跟上AI发展的需求。我们撞上的不仅是工艺墙,更是架构墙。

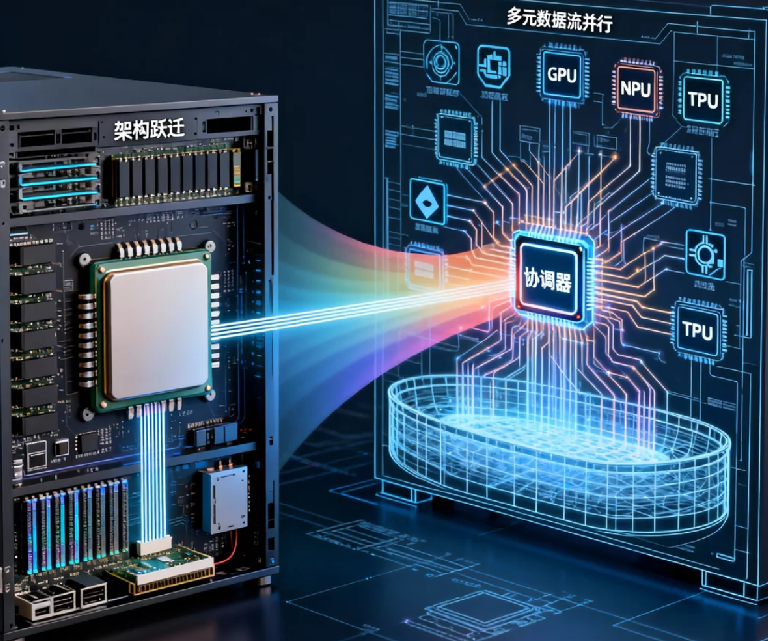

02 架构跃迁:从“以CPU为中心”到“以数据流为中心”

真正的变革不是“添加更多加速卡”,而是彻底重构服务器内部的计算拓扑和数据流。这种跃迁体现在三个核心维度上:

第一维度:计算单元从“通用处理器”到“专用异构阵列”

传统服务器的思路是“一个强大的CPU指挥一切”。而在智算服务器中,CPU的角色正在从“指挥官”退化为“协调员”。真正的计算主力变成了GPU、TPU、NPU等专用加速器阵列,它们通过NVLink、CXL等新一代高速互连技术直接通信,形成协同计算的“加速器网格”。

最先进的设计甚至开始采用“芯片粒(Chiplet)”技术,将不同类型的计算单元(CPU核心、AI加速核心、内存控制器、I/O接口)像乐高积木一样集成在同一个封装内,将原本板级的数据通信提升到芯片级,将延迟降低一个数量级,将带宽提升两个数量级。

第二维度:内存架构从“分层缓存”到“统一内存池”

传统内存架构的金字塔结构(寄存器-L1-L2-L3-主存-存储)在AI负载下效率低下。智算架构正朝着“统一内存”或“高带宽内存(HBM) ”的方向演进。

想象一下,GPU可以直接访问一个巨大的、统一编址的内存空间,而不是通过PCIe总线从系统内存中“搬运”数据。这不仅大幅减少了数据复制开销,更重要的是改变了编程模型——开发者可以更自然地表达数据并行,而不必被显式内存管理所困扰。苹果的M系列芯片、AMD的Instinct MI300X,都在这一方向上进行着开创性实践。

第三维度:互连拓扑从“星型总线”到“全连接网络”

当一台服务器内部集成了8颗甚至16颗AI加速芯片时,它们如何连接就决定了整体性能的上限。传统的PCIe总线像一条主干道,所有设备都要排队进出,极易拥堵。

新型智算服务器采用NVLink Switch或类似的片上网络(NoC)技术,让每颗加速芯片都能以超高带宽直接与其他芯片通信,形成一个全连接或近似全连接的网络。这不仅仅是带宽的提升,更是拓扑结构的质变——计算单元之间的关系从“主从”变为“对等”,真正实现了大规模并行计算所需的通信模式。

03 软硬件协同:算法、框架与硬件的重新对齐

架构跃迁不仅是硬件的革命,更是软件栈的全面重构。没有软件的配合,最先进的硬件也不过是昂贵的摆设。

框架与编译器的革命是关键。PyTorch、TensorFlow等主流框架正在深度集成针对特定硬件的优化后端。更值得关注的是MLIR(多级中间表示)等新一代编译器基础设施的出现,它们允许算法描述在不同抽象级别上进行优化,最终针对目标硬件生成高度优化的代码,实现了从“硬件适应软件”到“软件与硬件协同设计”的转变。

系统软件的“去中心化” 也在发生。在传统架构中,操作系统内核掌握着所有资源的调度权。但在智算场景下,这种集中式调度可能成为瓶颈。新的趋势是让加速器拥有自己的轻量级调度器,甚至允许应用程序更直接地管理硬件资源,操作系统则退居为资源的安全隔离者而非绝对控制者。

算法与硬件的共同进化则是最激动人心的部分。当Transformer成为大模型的主流架构时,芯片厂商迅速推出了针对注意力机制的专用硬件单元。同样,当混合专家模型(MoE)展现出巨大潜力时,支持动态路由和稀疏计算的硬件设计也开始涌现。这种算法创新驱动硬件设计,硬件能力赋能算法探索的良性循环,正在以前所未有的速度推动整个领域前进。

04 经济性重构:从“拥有成本”到“计算产出”的指标革命

架构跃迁最终要回答一个商业问题:这值得吗?评估标准需要根本性改变。

在通用计算时代,我们关注的是“每美元能买到的CPU核心数”或“每瓦特能提供的通用计算能力”。在智算时代,核心指标变成了:

- 每美元能训练多少Token?

- 每瓦特能支撑多少并发推理请求?

- 从模型加载到首次推理的延迟是多少?

这种指标转变的背后,是从“计算能力”到“AI能力”的价值重估。一家自动驾驶公司发现,尽管专用AI服务器的采购成本是通用服务器的2.5倍,但其训练效率提升了8倍,这意味着他们可以将模型迭代周期从三个月缩短至两周——这种时间价值在激烈竞争的市场中,远超过硬件成本差异。

更微妙的是总体拥有成本(TCO)的重构。智算服务器的电力消耗可能更高,但如果训练时间缩短60%,那么电力总消耗可能反而降低;专用硬件的利用率可能高达70-80%,而通用服务器在AI负载下可能只有15-20%。看似昂贵的专用硬件,在真实工作负载下的经济性可能远超预期。

05 组织与生态的适应:跨越技能与供应链的鸿沟

最后,架构跃迁的最大挑战往往不在技术,而在人与组织。

技能结构的转变是首当其冲的挑战。当基础设施从通用服务器变为异构智算集群时,运维团队需要理解的不再只是Linux和虚拟化,还有CUDA、RoCE、高速网络拓扑和分布式训练框架。开发人员则需要掌握如何将算法映射到特定硬件,如何优化数据流水线以避免瓶颈。这催生了新的角色——“MLOps工程师”、“AI系统架构师”,他们横跨算法、软件和硬件,成为新范式的关键纽带。

供应链与部署模式的革新同样深刻。传统的服务器供应链是标准化的、可预测的。而高端AI加速器供应紧张、迭代迅速,迫使企业采用更灵活的策略——混合使用云上实例和自有硬件,甚至采用“计算即服务”的模式,将硬件复杂性完全外包。

开源与开放的生态建设成为竞争焦点。在通用计算时代,x86和Linux形成了事实上的标准生态。在智算时代,生态竞争刚刚开始:NVIDIA的CUDA生态、开源且硬件无关的OpenXLA框架、各大云厂商的托管服务,都在争夺开发者的心智。胜出的可能不是性能最强的硬件,而是生态最繁荣、开发者最易用的平台。

回到那家AI公司的困境。他们没有继续在通用架构上做优化,而是启动了为期18个月的“智算架构转型”计划。

第一阶段,他们引入了第一批异构服务器,将最耗时的训练任务迁移过去,获得了5倍的加速。第二阶段,他们重构了数据流水线和训练框架,充分利用了硬件特性,将效率进一步提升2倍。第三阶段,他们甚至与芯片厂商合作,针对自己的特定模型系列进行了微架构级别的协同优化。

今天,他们的训练集群看起来完全不同:不再是整齐划一的通用服务器机柜,而是由不同类型的计算单元组成的“异构计算阵列”——一些节点专攻大规模预训练,一些优化了推理吞吐,还有一些专门处理数据预处理。更重要的是,他们建立了一套智能调度系统,能够根据任务特性自动选择最合适的硬件组合。

这种转变带来的不仅是效率提升,更是业务能力的质变。他们能够尝试以前计算成本无法承受的新型模型架构,能够为不同客户提供定制化的模型优化服务,甚至开始将自己优化的计算架构作为一项服务对外提供。

从通用计算到异构智算的跃迁,本质上是从“提供计算能力”到“提供智能创造能力”的转变。当服务器不再只是运行代码的容器,而是孕育智能的母体时,基础设施的价值就从成本中心,跃升为创新引擎的核心部件。

下一次当你规划AI基础设施时,真正的问题或许不是“我们需要多少算力”,而是“我们需要什么样的计算架构来释放我们算法的全部潜力?” 答案,将决定你在智能时代的竞争起跑线。